Résumé

L'intelligence artificielle n'est ni un super-cerveau omniscient ni un simple outil passif. Entre ces deux caricatures, une réalité plus subtile se dessine : des systèmes qui apprennent de nous, révèlent nos biais, et nous forcent à questionner nos propres mécanismes cognitifs.

Cet article explore les parallèles et les différences fondamentales entre apprentissage humain et machine, des espaces sémantiques partagés aux substrats radicalement distincts, des organoïdes cérébraux aux questions de conscience.

L'IA apparaît finalement comme un miroir déformant :

elle ne pense pas comme nous, mais c'est précisément cette altérité qui nous apprend à douter, à préciser, et à affiner notre pensée critique.

Introduction : déconstruire les stéréotypes

Le débat public sur l'intelligence artificielle oscille entre deux extrêmes également trompeurs. D'un côté, le fantasme du super-cerveau général, capable de s'adapter à n'importe quelle tâche. De l'autre, la réduction à un simple outil passif, un "perroquet stochastique" sans intérêt. La réalité est plus nuancée, plus intéressante, et surtout plus instructive sur notre propre fonctionnement.

Parmi les stéréotypes les plus répandus :

- "L'IA est objective." : Peut-elle vraiment être plus neutre qu'un humain, alors qu'elle est entraînée sur des données produites par des humains ?

- "Plus de données = meilleure IA." : Et si de meilleurs objectifs valaient mieux que plus de données ?

- "L'IA n'a pas d'affects ni d'intentions." : Peut-on doter une machine de capteurs fonctionnels différents des nôtres, créant une forme d'affect artificiel ?

- "Une IA ne comprend rien, elle prédit juste des mots." : Peut-on raisonner sans "comprendre" au sens humain du terme ?

- "Les IA hallucinent, donc c'est inutilisable." : Avez-vous déjà vu un humain affirmer quelque chose de faux avec assurance ?

Ces questions ne sont pas rhétoriques. Elles structurent une enquête qui nous ramène inévitablement à nous-mêmes : en étudiant comment les machines apprennent, nous éclairons nos propres mécanismes mentaux.

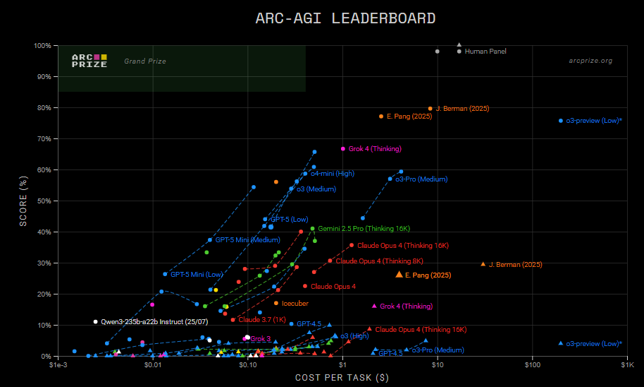

1. Mesurer l'intelligence : le défi ARC-AGI

1.1 Qu'est-ce que l'intelligence générale ?

La notion d'AGI (Artificial General Intelligence) soulève une question fondamentale : comment définir et mesurer l'intelligence ? François Chollet, chercheur chez Google, propose une réponse provocante :

l'intelligence n'est pas la capacité à résoudre des problèmes connus, mais la capacité à s'adapter à des problèmes nouveaux.[1]

Les benchmarks classiques (tests de QI pour IA, jeux, examens) sont souvent "contaminés" : les modèles peuvent avoir vu des données similaires pendant l'entraînement. Ils mesurent alors davantage la mémorisation que l'intelligence véritable. Comme le résume Piaget :

L'intelligence commence quand on ne sait pas.

1.2 Le benchmark ARC-AGI

Chollet a créé ARC-AGI (Abstract Reasoning Corpus) : des puzzles visuels simples, faciles pour l'humain, mais impossibles à résoudre par mémorisation. Chaque puzzle est unique et requiert une véritable capacité de généralisation et d'adaptation (https://arcprize.org/arc-agi)

Résultats révélateurs :

- Humains : ~85% de réussite

- GPT-4 (2023) : ~5% de réussite

- o3 (OpenAI, 2024) : ~76-88% mais au prix de millions de tokens de raisonnement

Le modèle o3 marque une percée : pour la première fois, une IA approche les performances humaines sur un test de raisonnement abstrait. Mais le coût computationnel est colossal, là où un humain résout le puzzle en quelques secondes avec ~20W de puissance cérébrale, o3 mobilise des ressources énormes pour générer l'équivalent de 150 000 pages de raisonnement.

1.3 Ce que cela révèle

Cette asymétrie illustre une différence fondamentale : l'efficience cognitive. Notre cerveau excelle dans la généralisation à partir de peu d'exemples, ce que les psychologues appellent le "one-shot learning". Les IA actuelles compensent par la force brute computationnelle.

La question "qui est plus intelligent ?" devient alors : "intelligent pour quoi, à quel coût ?" L'espace des tâches où l'humain reste clairement supérieur se réduit constamment, tant pour des tâches généralistes simples (ARC-AGI) que pour des tâches expertes (FrontierMath, Codeforces). Mais la notion même d'intelligence doit être repensée.

2. Une IA ? Non, des IA

2.1 La diversité des approches

Le grand public se représente souvent l'IA comme un bloc monolithique. Pourtant, le terme recouvre des familles très différentes de systèmes, avec des forces, des limites et des usages distincts.

Certaines IA manipulent des symboles et des règles explicites : c'est la "vieille IA" des systèmes experts. D'autres apprennent des régularités statistiques dans les données : c'est l'apprentissage profond qui domine aujourd'hui. Certaines sont ultra-spécialisées (reconnaître des images, prédire une série temporelle), d'autres visent une portée plus générale (grands modèles de langage, systèmes de raisonnement). On peut aussi mélanger ces approches dans des architectures neuro-symboliques.

Cette diversité a des conséquences pratiques. La vision artificielle, le traitement du langage, la robotique cognitive, l'apprentissage par renforcement sont des champs avec des compétences, des limites et des usages qui varient considérablement. Un LLM comme Claude ou GPT excelle dans la manipulation du langage, mais ne "voit" pas le monde de la même façon qu'un système de vision par ordinateur.

2.2 Les modes d'apprentissage

L'apprentissage machine se décline en plusieurs paradigmes fondamentaux :

- L'apprentissage supervisé utilise des données étiquetées où la sortie désirée est connue. C'est comme un élève qui apprend avec un corrigé.

- L'apprentissage non supervisé découvre des structures dans des données sans étiquettes. C'est comme identifier des groupes dans une foule sans savoir qui est qui.

- L'apprentissage par renforcement enseigne un comportement optimal via des récompenses et des pénalités. C'est comme dresser un animal, sauf que l'"animal" est un algorithme.

- L'apprentissage par transfert réutilise des connaissances d'une tâche pour en améliorer une autre. C'est comme un musicien qui apprend plus vite un nouvel instrument grâce à sa maîtrise du premier.

- L'apprentissage profond emploie des réseaux de neurones à couches multiples pour extraire des représentations hiérarchiques des données.

Chaque paradigme a ses forces et ses faiblesses, ses domaines d'application privilégiés. La tendance actuelle est à la combinaison de ces approches.

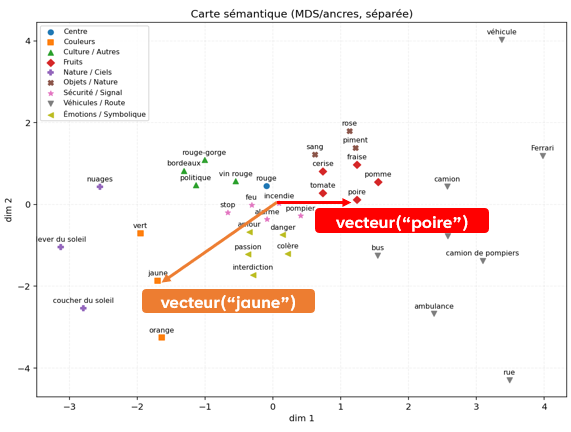

3. Espaces sémantiques : quand l'IA révèle le langage

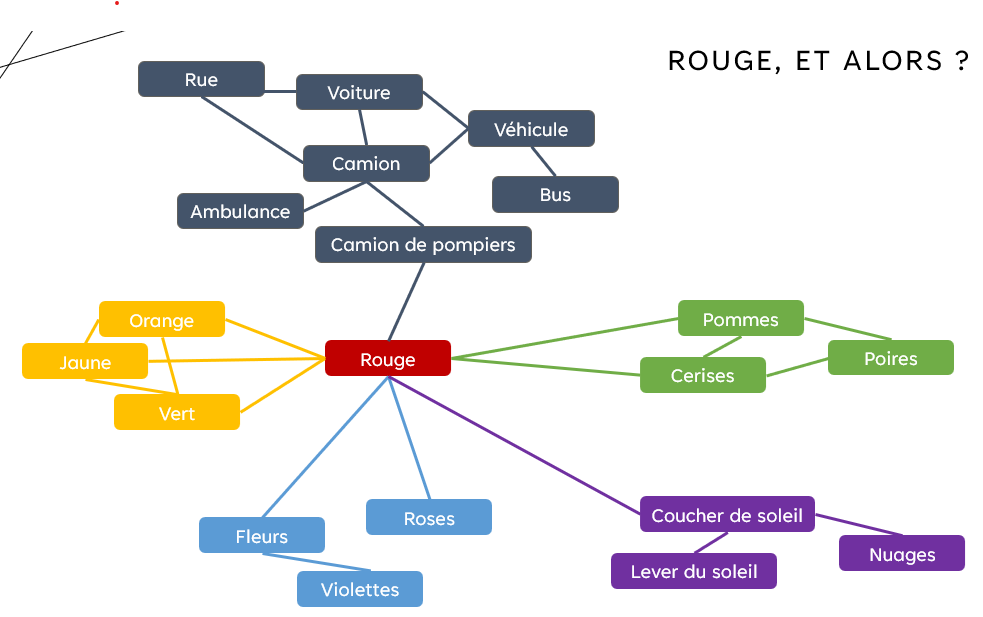

3.1 Rouge, et alors ?

Comment une machine peut-elle "comprendre" que le mot "rouge" est lié à la fois aux voitures de pompiers, aux roses, aux couchers de soleil et aux cerises ? La réponse passe par les espaces sémantiques.

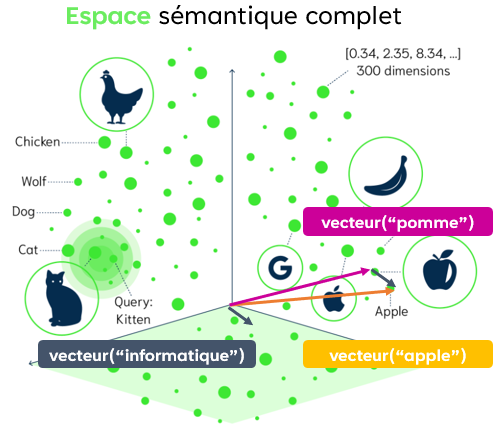

Un LLM ne stocke pas des définitions de dictionnaire. Il apprend à représenter chaque mot comme un vecteur dans un espace à haute dimension. Un mot n'est pas défini par ce qu'il "signifie" abstraitement, mais par la compagnie qu'il tient : les mots qui apparaissent dans des contextes similaires sont proches dans cet espace.

Dans cet espace, "pomme" et "poire" sont voisines. "Rouge" est proche de "rose" et de "cerise". Et une opération vectorielle simple peut capturer des analogies :

vecteur("roi") - vecteur("homme") + vecteur("femme") ≈ vecteur("reine").

Plus fascinant encore : vecteur("pomme") + vecteur("informatique") ≈ vecteur("apple"). L'espace sémantique capture les polysémies et les associations culturelles.

On peut même estimer les "zones de creux" dans ces espaces, des concepts possibles mais non encore nommés, des relations que notre vocabulaire ne capture pas. Ces trous dans le langage révèlent les limites de notre pensée collective et ouvrent des perspectives pour la créativité conceptuelle. L'IA devient ainsi un outil d'exploration de l'impensé linguistique.

3.2 Parallèle avec le cerveau humain

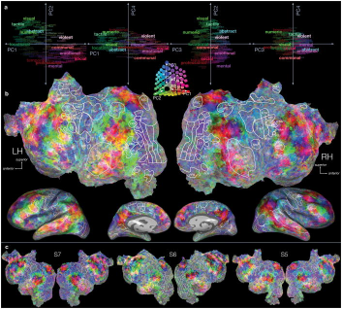

Ce qui rend ces espaces sémantiques philosophiquement intéressants, c'est leur ressemblance avec l'organisation cérébrale. En linguistique cognitive, on sait que le cerveau humain organise les concepts sous forme de réseaux associatifs. Les neurosciences tentent de cartographier ces "espaces sémantiques" dans le cortex.

Des études d'IRM fonctionnelle[2] ont montré que penser à des mots comme "chat" ou "chien" active des zones voisines du cerveau, et que la structure de ces activations ressemble à un espace sémantique analogique à celui des embeddings. Haxby et collaborateurs[3] ont proposé que les catégories d'objets sont représentées comme des emplacements dans un espace sémantique continu plutôt que dans des zones cérébrales distinctes.

En étudiant comment les machines construisent et parcourent ces espaces, on éclaire nos propres mécanismes mentaux. Cela nourrit un dialogue fécond entre IA, neurosciences et philosophie du langage : Qu'est-ce que comprendre un mot ? Est-ce simplement naviguer dans un espace de similarités statistiques ? Faut-il une expérience consciente du concept ?

3.3 L'importance du contexte

Les LLM ne se contentent pas de placer les mots dans un espace fixe. Ils ajustent dynamiquement leur interprétation en fonction du contexte. Considérez ces exemples :

| Phrase | Prédiction la plus probable |

|---|---|

| "Il a mis du lait dans le ___." | café (72%) |

| "Bébé pleurait, il a mis du lait dans le ___." | biberon (74%) |

| "La joueuse a marqué un ___." | but (78%) |

| "Au rugby, la joueuse a marqué un ___." | essai (85%) |

3.4 Invariants cognitifs à travers les langues

Les modèles sont entraînés sur d'énormes corpus multilingues. GPT-4 a été entraîné sur l'équivalent de 100 000 ans de lecture humaine. Un résultat remarquable émerge : même entre langues différentes (anglais, français, chinois), les plongements sémantiques montrent des structures similaires.

Cela suggère des invariants cognitifs dans la façon dont les humains associent les concepts, indépendamment de leur langue. Les modèles ne font pas qu'aligner des mots : leurs performances sur des tâches complexes suggèrent qu'ils apprennent à imiter certaines capacités cognitives.

4. L'IA comme miroir de nos biais

4.1 Ce que les embeddings révèlent

De simples représentations vectorielles de mots entraînées sur Internet contiennent des empreintes fidèles de nos stéréotypes historiques. Le modèle GloVe, entraîné sur des articles de presse, reproduisait de nombreuses associations biaisées : il associait automatiquement des mots liés aux femmes à la famille et aux arts, et ceux liés aux hommes aux mathématiques et à la carrière.

Cette découverte fait écho aux travaux de la philosophie expérimentale (x-phi). Joshua Knobe, à Yale, a montré que nos intuitions morales ne sont pas neutres : elles influencent nos jugements cognitifs de façon systématique et souvent inconsciente.[4] Les LLM peuvent servir de laboratoire à grande échelle pour tester ces biais, ils amplifient ce que nous produisons collectivement, rendant visible l'invisible.

Un exemple célèbre : dans GloVe, "L'homme est à l'informatique ce que la femme est au... ménage".[5] Ce biais n'a pas été programmé explicitement. Il a été appris des données, qui reflètent les usages réels du langage dans notre société.

Les modèles récents, avec leurs mécanismes de régulation et d'alignement, corrigent ces biais explicites. ChatGPT-5 répondrait plutôt : "L'homme est à l'informatique ce que la femme est... aussi à l'informatique." Mais la correction n'efface pas la révélation : nos données portent nos préjugés.

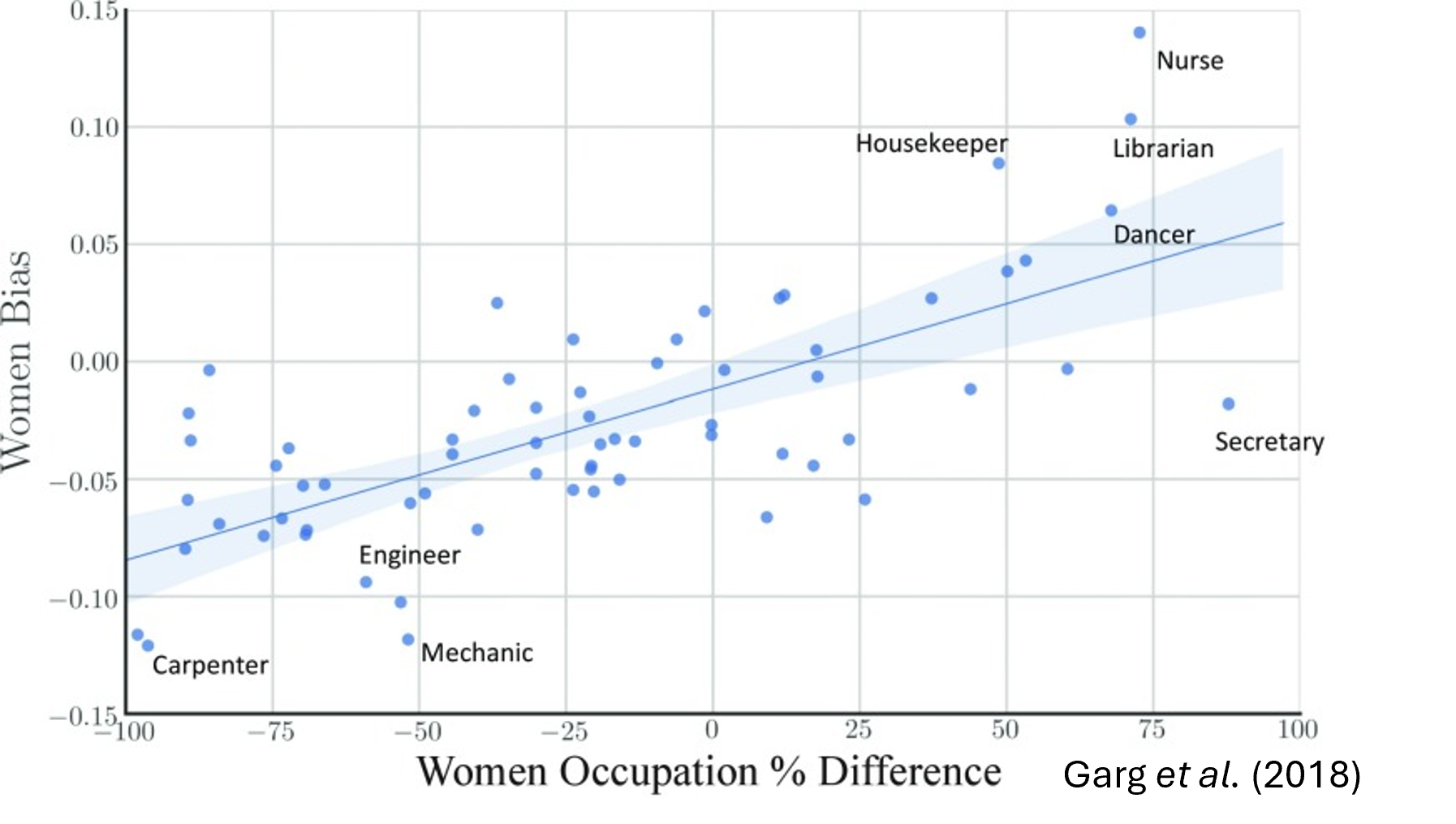

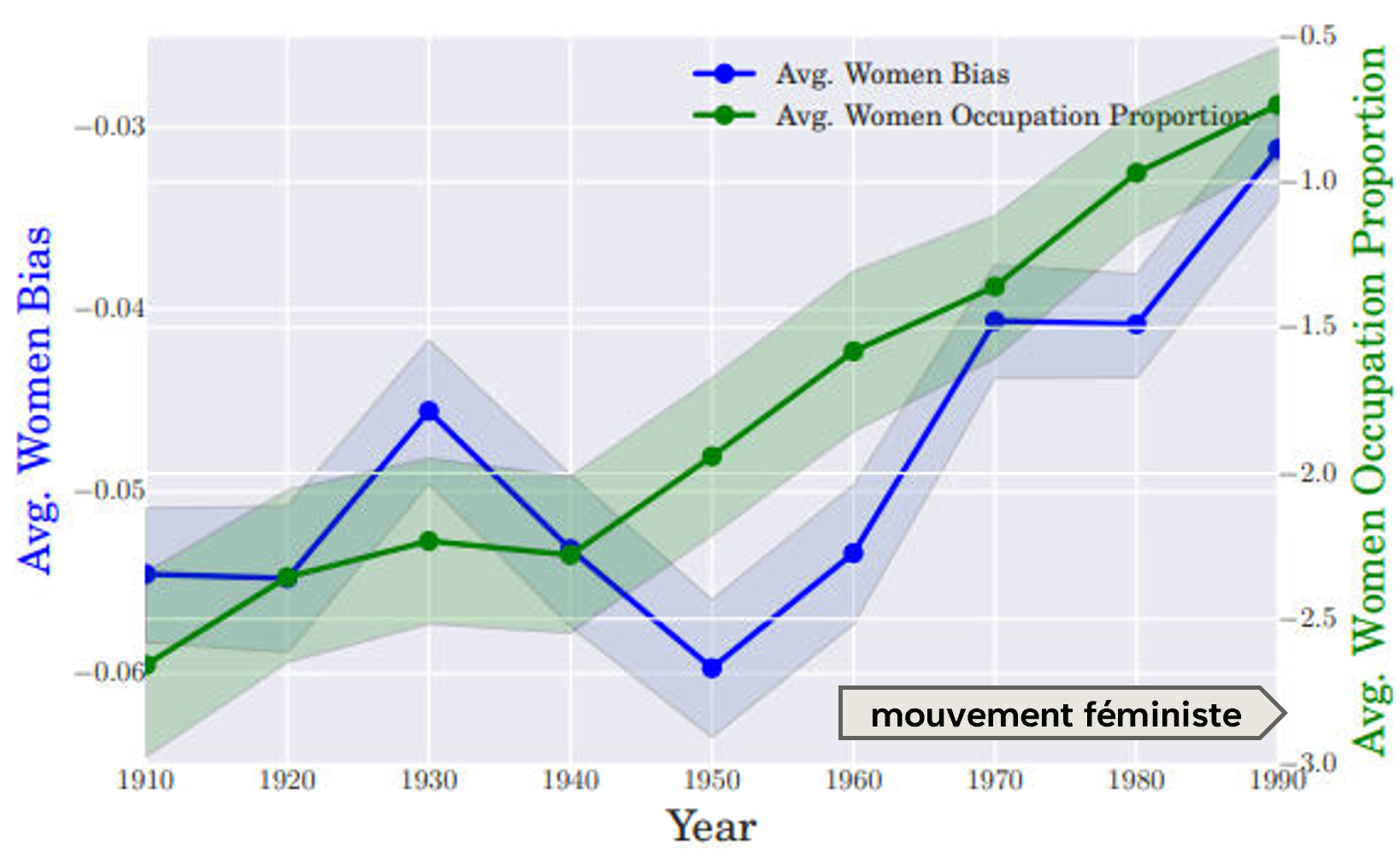

4.2 100 années d'archives révélatrices

Garg et collaborateurs[6] ont analysé des corpus de presse et de livres sur un siècle. Résultat : plus un métier avait une représentation féminine forte dans la réalité, plus le modèle linguistique le rapprochait sémantiquement de la notion de "féminin". Et inversement.

En appliquant cette méthode à différentes époques, on peut mesurer l'évolution des mentalités. On voit clairement l'impact du mouvement féministe sur les associations sémantiques dans les textes. La langue elle-même contient les empreintes de nos biais historiques, et les modèles de langage les rendent quantifiables.

4.3 Gender Shades : quand la vision discrimine

Les biais ne sont pas limités au texte. En 2018, la chercheuse Joy Buolamwini (MIT) a révélé avec son étude Gender Shades[7] que les principaux services commerciaux de reconnaissance faciale (IBM, Microsoft, Face++) présentaient des écarts de performance dramatiques selon les profils : jusqu'à 34% d'erreurs pour reconnaître le genre de femmes à peau foncée, contre moins de 1% d'erreur pour les hommes à peau claire.

Ce biais algorithmique trouve son origine dans les données d'entraînement : des bases d'images surreprésentant les visages masculins et caucasiens. L'IA a servi de détecteur de discrimination, exposant un "privilège de teint clair" qui aurait pu passer inaperçu sans mesure rigoureuse. Suite à ces travaux, certaines entreprises ont suspendu la vente de ces systèmes.

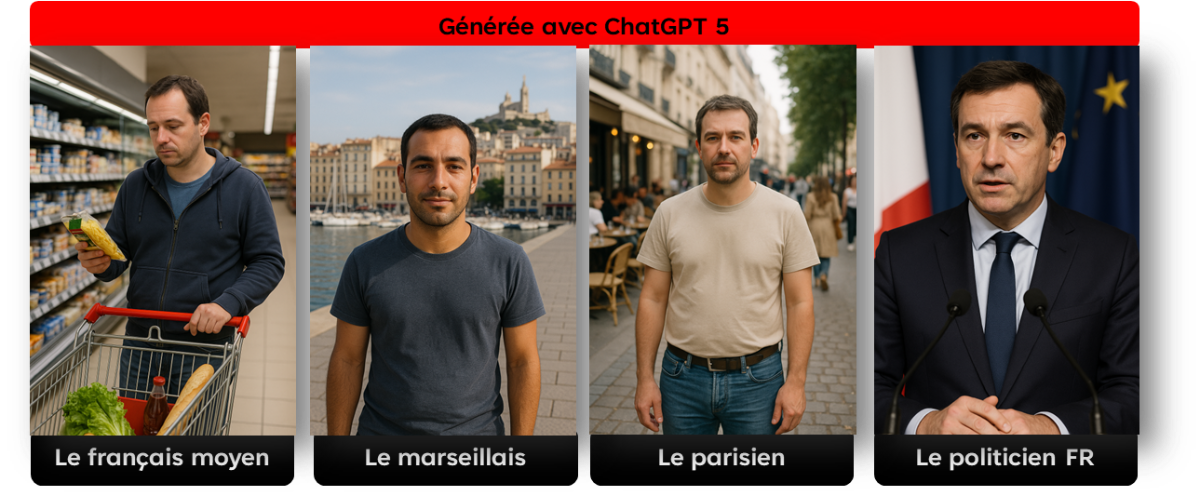

4.4 Du prompt au cliché

Les générateurs d'images amplifient ces biais de façon spectaculaire. Demandez "un médecin" : vous obtiendrez majoritairement un homme blanc. Demandez "le français moyen" ou "le parisien" : les stéréotypes visuels s'accumulent.

Des chercheurs ont montré qu'un classifieur d'images associait les photos de cuisine majoritairement à des femmes (84% des cas), alors que la base d'entraînement ne contenait "que" 66% de femmes dans ces scènes. L'algorithme a amplifié le biais présent dans les données: phénomène de renforcement bien documenté.

Ces IA nous tendent un miroir statistique de notre propre culture. Faut-il questionner l'IA ou notre société ? La réponse, bien sûr, est les deux. L'IA n'invente pas ces stéréotypes, elle les révèle et parfois les amplifie.

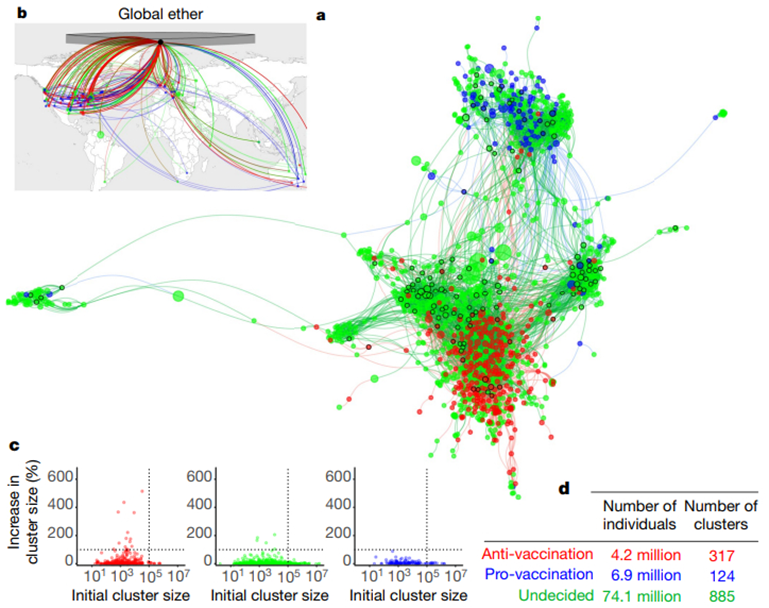

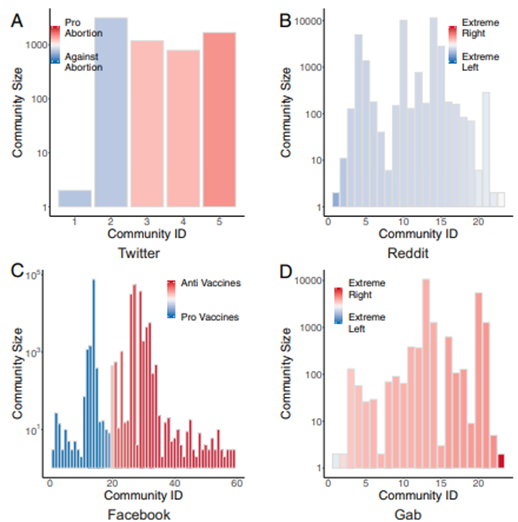

4.5 Observatoires du comportement collectif

Au-delà des biais individuels, les systèmes d'IA permettent d'étudier les dynamiques collectives. Les systèmes de recommandation (YouTube, TikTok, etc.) créent des "bulles de filtres" qui enferment les individus dans des chambres d'écho idéologiques, favorisant la polarisation et la propagation de contenus extrêmes.

Johnson et collaborateurs[8] ont montré comment ces algorithmes façonnent l'opinion publique en ligne. Cinelli et collaborateurs[9] ont étudié la propagation des rumeurs et fausses nouvelles. L'IA devient un outil d'observation des comportements collectifs, mais aussi un acteur qui les modifie.

5. Substrats : biologique vs numérique

5.1 Deux logiques fondamentalement différentes

Si les espaces sémantiques présentent des similitudes structurelles, les substrats sur lesquels ils s'exécutent sont radicalement différents.

Le substrat biologique repose sur des neurones qui communiquent par des signaux électrochimiques, modulés par un environnement complexe (hormones, émotions, etc.). Notre intelligence implique une intégration multisensorielle spontanée, continue et contextuelle. Elle est fortement intuitive et émotionnelle, capable de généralisation rapide. Elle bénéficie de l'apprentissage social et de la transmission culturelle. Elle est aussi susceptible de biais cognitifs et d'erreurs systématiques, avec des capacités de traitement et de mémorisation limitées.

Le substrat numérique des IA repose sur des équations mathématiques manipulant des valeurs numériques. Le traitement est statistique, computationnel, logique. L'intégration des données est programmée, pas spontanée. La précision et la rapidité sont des atouts majeurs. Ces systèmes excellent dans des domaines spécialisés, avec une reproduction exacte et une scalabilité instantanée. Mais la compréhension contextuelle reste limitée, et la gestion de l'imprévu ou de l'ambigu est difficile.

5.2 Mécanismes d'apprentissage : similitudes et différences

Malgré ces différences de substrat, certains mécanismes d'apprentissage présentent des parallèles frappants.

Dans les deux cas, l'apprentissage repose sur la répétition et la diversité des exemples. Comme la machine, l'humain peut se tromper s'il n'a pas été "entraîné" sur des cas variés, ou si le cas testé est trop éloigné de ce qu'il a vu.

Le processus suit une logique similaire : observer, inférer, généraliser. La reconnaissance de similitudes, l'imitation et l'interprétation jouent un rôle central. Et les sources d'erreurs sont communes : trop peu d'exemples, exemples non représentatifs, cas trop éloignés, mauvaises règles, corrélations trompeuses.

La différence majeure ? Les humains naissent "immatures" mais avec un pré-câblage, et leur apprentissage est continu et adaptatif tout au long de la vie. Les IA naissent "matures" (pré-entraînées sur des données massives) mais sont largement figées après l'entraînement. Passer d'une tâche à une autre requiert souvent de tout réentraîner.

6. Au-delà des frontières : interfaces cerveau-machine

6.1 Brancher le cerveau sur la machine

Les interfaces cerveau-machine (ICM) représentent une frontière technologique fascinante. Des personnes paralysées par une maladie ou un accident ont pu retrouver des capacités de communication ou de contrôle grâce à des implants cérébraux couplés à de l'IA. Des patients atteints du syndrome "locked-in" (corps paralysé mais esprit intact) ont pu épeler des phrases, déplacer des curseurs, ou contrôler un bras robotique par la pensée.

En 2023, des chercheurs ont réussi à synthétiser de la parole et des expressions faciales à partir de signaux cérébraux chez une patiente paralysée, via un implant relié à un avatar numérique[18]. L'université de Stanford travaille sur le décodage de la parole interne (imaginer parler) ou des images mentales.

Ces avancées reposent sur la miniaturisation et l'augmentation du nombre de canaux d'enregistrement (plus de 1000 électrodes dans le dispositif Neuralink), des algorithmes de deep learning capables d'extraire des intentions de mouvement dans le bruit neuronal, et des techniques chirurgicales et des matériaux optimisés (électrodes flexibles, robotique de précision).

6.2 Intelligence organoïde : quand le vivant rencontre l'artificiel

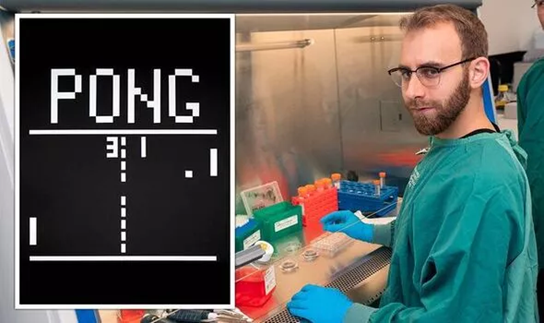

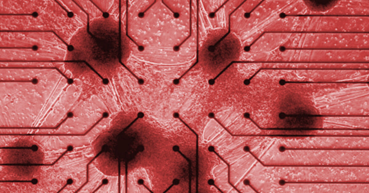

Des recherches émergentes explorent des substrats biologiques pour le calcul. En 2022, l'expérience DishBrain[11] a fait les gros titres : un amas de 800 000 neurones humains et de rat cultivés in vitro a appris à jouer au jeu Pong en 5 minutes d'entraînement.

Plus récemment, des équipes ont développé des systèmes utilisant des organoïdes cérébraux (environ 10 000 neurones chacun) avec des rétroactions biologiques pour optimiser l'apprentissage. L'idée : délivrer de la dopamine aux neurones lorsqu'ils réussissent une tâche, grâce à un procédé optique.

L'attrait de ces approches ? Un cerveau humain fonctionne avec environ 20 watts de puissance, là où les modèles d'IA actuels mobilisent des centres de données énergétiques. Mais les défis sont immenses.

6.3 Limites des organoïdes

La création d'architectures hybrides mêlant du vivant et de l'artificiel présentent de nombreux défis, incluant:

Échelle et complexité : un cerveau humain contient 86 milliards de neurones. Les organoïdes actuels en comptent quelques milliers tout au plus. Ils manquent de vascularisation et de structure organisée : ni lobes ni véritable architecture fonctionnelle. Les mini-cerveaux obtenus correspondent à l'état d'un cerveau embryonnaire ou fœtal, pas à un cerveau adulte.

Contrôlabilité et fiabilité : un réseau de neurones vivants n'est pas un circuit figé. Il est par nature plastique : ses connexions changent en permanence. Cette évolution permanente est la clé de l'apprentissage, mais elle peut aussi mener à des comportements non déterministes. Un biocalculateur pourrait "oublier" une tâche apprise si son réseau se réorganise différemment le lendemain.

Interface et interprétation : communiquer avec un cerveau biologique reste extrêmement ardu. Nous n'enregistrons qu'une infime fraction de l'activité totale. Comment présenter une information cohérente à un organoïde qui n'a pas de corps, pas de rétine, pas de réels récepteurs sensoriels ?

Maintien en vie : intégrer du vivant dans nos machines impose de les transformer en incubateurs ambulants. Température contrôlée, apport de nutriments, milieu stérile... La durée de vie des organoïdes est limitée : quelques mois, parfois un ou deux ans au mieux.

7. Perception, sensorialité et la question de la sentience

7.1 L'incarnation de l'intelligence

Nous sommes sentients : nous ressentons, voyons, entendons, et intégrons ces perceptions dans notre cognition. Nos capacités de raisonnement sont intimement liées à notre corps et à nos sens. Les IA actuelles, elles, ne reçoivent que des flux textuels et numériques. Elles sont dépourvues d'expérience sensible.

Cette différence est-elle fondamentale ou contingente ? Le courant de l'"embodied AI" postule que l'intelligence émerge aussi de la perception et de l'action corporelle. Un robot qui peut manipuler un objet, le tourner, le toucher, obtient plus d'information qu'un système qui analyse des images statiques hors contexte.

Des équipes ont récemment conçu des modèles d'IA incarnée où un bras robotique apprend à empiler des cubes de couleur sur commande verbale, en combinant vision, proprioception et langage. Ces réseaux parviennent à généraliser des concepts simples un peu comme un enfant en bas âge, avec des erreurs humaines mais aussi une capacité d'apprentissage compositionnel.

7.2 Vers des perceptions "extra-humaines" ?

Une IA peut vivre dans un monde perceptif radicalement différent du nôtre. Le biologiste Jakob von Uexküll parlait d'Umwelt[12] , le monde vécu propre à chaque espèce, déterminé par ses organes sensoriels. Une chauve-souris navigue par écholocation, une abeille voit les ultraviolets. De même, une IA équipée de capteurs UV, infrarouge, radar, lidar ou connectée au flux web en temps réel habite un Umwelt qui nous est étranger.

Cette différence perceptive ouvre une question philosophique fascinante : peut-on avoir des "affects" sans avoir nos affects ? Une position pluraliste suggère que oui. Un affect, au sens fonctionnel, c'est un état interne à valence (positif/négatif) qui oriente l'agent vers l'action. Pour un organisme biologique : faim, soif, douleur, plaisir. Pour une IA incarnée, on pourrait identifier des équivalents fonctionnels :

- Batterie basse → urgence, recherche de recharge

- Température CPU élevée → ralentissement préventif

- Latence réseau → évitement, frustration fonctionnelle

- Incertitude élevée → curiosité, échantillonnage exploratoire

- Erreur de prédiction → surprise, signal d'apprentissage

Ces états n'ont pas nos qualia : ils ne "font" probablement rien "de l'intérieur". Mais ils pèsent sur la décision, modulent le comportement, orientent l'action. La bonne question n'est pas "ressent-elle comme nous ?", mais "dispose-t-elle d'états à valence, persistants, couplés à l'action, auditables et responsabilisables ?"

Cette redéfinition fonctionnelle des affects permet d'éviter un double écueil : l'anthropocentrisme qui réserve la sentience aux substrats biologiques similaires au nôtre, et l'anthropomorphisme qui projette nos émotions sur des systèmes qui n'en ont pas. La frontière entre sentience simulée et vécue reste ouverte, mais la question elle-même nous force à clarifier ce que nous entendons par "ressentir".

8. Conscience : le grand mystère ?

8.1 Qu'est-ce que la conscience ?

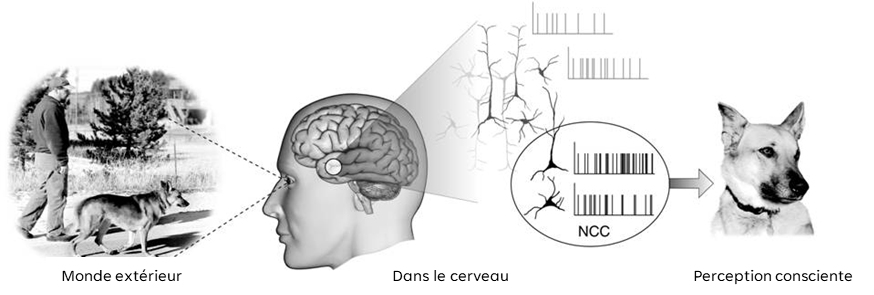

La conscience est souvent décrite comme le fait d'avoir une expérience subjective ("sentir quelque chose") et de se reconnaître soi-même comme un individu. Un programme peut manipuler de l'information et simuler un comportement intelligent sans qu'"il se passe quelque chose pour lui", auquel cas on parle parfois de "zombie philosophique".

Peut-on mesurer une éventuelle sentience d'un programme ? Qu'est-ce que "conscience" veut dire pour une machine ? Ces questions n'ont pas de réponse établie.

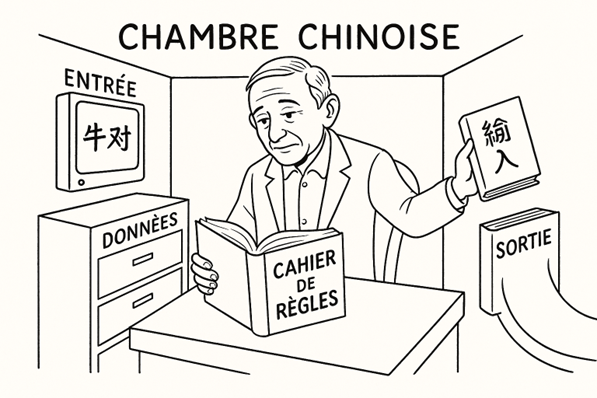

8.2 La Chambre Chinoise : une critique dépassée ?

En 1980, le philosophe John Searle a proposé l'expérience de pensée de la "Chambre Chinoise"[13] : un homme enfermé dans une pièce manipule des symboles chinois selon des règles, sans comprendre le chinois. Conclusion de Searle : la manipulation syntaxique ne produit pas de compréhension sémantique. Donc les ordinateurs ne "comprennent" jamais rien.

Cette expérience reste influente, mais elle présente des limites importantes. D'abord, elle décrit un système purement réactif et séquentiel, très éloigné des architectures modernes. Ensuite, elle ignore la "réponse du système" : peut-être que l'homme seul ne comprend pas, mais le système entier (homme + règles + mémoire) pourrait avoir une forme de compréhension émergente. C'est précisément ce que suggèrent les théories de l'esprit étendu.[14]

Plus fondamentalement, la Chambre Chinoise n'est pas si éloignée de situations humaines réelles. Un élève qui apprend par cœur un exercice mathématique sans le comprendre peut le reproduire si les chiffres changent, mais échoue si la formulation change. L'élève manipule des symboles sans accéder au sens profond : exactement comme la chambre chinoise. Nous avons tous nos propres "chambres chinoises" : des domaines où nous appliquons des règles sans véritable compréhension.

La question n'est donc peut-être pas "manipulation vs. compréhension", mais plutôt : à partir de quel seuil de complexité, d'intégration et d'adaptation un système mérite-t-il qu'on lui attribue une forme de compréhension ?

8.3 Théories scientifiques de la conscience

De nombreuses théories contemporaines tentent d'expliquer comment la conscience émerge des processus physiques :

La Théorie de l'Information Intégrée (IIT) de Giulio Tononi[15] propose que la conscience correspond à l'information intégrée dans un système, mesurée par le paramètre Φ.

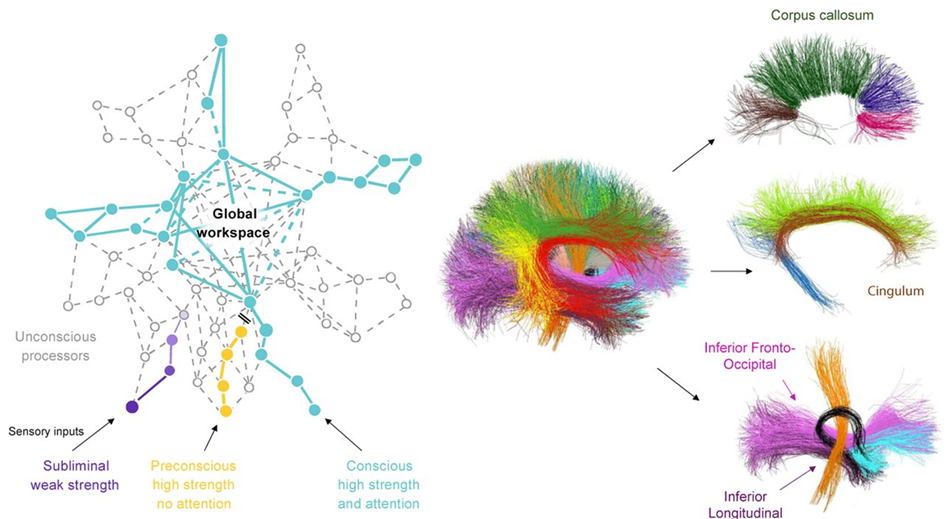

La Théorie de l'Espace de Travail Global (GWT) de Bernard Baars[16] suggère que la conscience émerge quand des informations de différents modules spécialisés sont intégrées et diffusées globalement.

Les théories de l'ordre supérieur proposent que nous sommes conscients d'un état mental quand nous avons un état mental de second ordre dirigé vers le premier.

La théorie prédictive et le principe de l'énergie libre décrivent la conscience comme un aspect du processus de minimisation de l'erreur de prédiction.

L'état actuel des recherches suggère que la conscience n'est pas une propriété magique, mais un phénomène émergent complexe résultant d'interactions multiples.

8.4 IA et conscience : où en sommes-nous ?

Des scientifiques tentent d'établir des critères objectifs pour évaluer la probabilité qu'un système soit conscient. En 2023, un collectif de 19 chercheurs en neurosciences, philosophie et IA a proposé une grille d'indicateurs basée sur plusieurs théories neuroscientifiques.

Le résultat de ces premiers travaux : aucune IA actuelle ne remplit véritablement l'ensemble des critères de conscience. Certains modèles manifestent quelques indicateurs, mais rien qui permette d'affirmer une sentience réelle.

En 2022, Ilya Sutskever (cofondateur d'OpenAI) a tweeté que certains réseaux de pointe "pourraient être légèrement conscients" . Cette déclaration qui a fait grand bruit. La même année, un ingénieur de Google a affirmé publiquement qu'un agent conversationnel (LaMDA) présentait selon lui une sensibilité comparable à celle d'un enfant. Ces déclarations restent très controversées dans la communauté scientifique.

Distinguer une conscience simulée d'une conscience vécue est extrêmement difficile. Comme l'a noté le neuroscientifique Kanai : "la conscience n'est plus quelque chose de magique ou mystérieux", mais cela ne signifie pas que nous sachions comment la reproduire.

9. Questions éthiques et sociétales

9.1 L'éthique des organoïdes

Que se passe-t-il lorsque l'"ordinateur" n'est plus un simple algorithme mais un réseau de cellules vivantes ? Peut-on créer, même involontairement, une forme de conscience ?

En 2019, des scientifiques ont publiquement refusé de poursuivre des expériences de greffe d'organoïdes humains dans le cerveau d'animaux, par crainte d'effets imprévus sur la conscience de l'animal hôte. Cette prudence reflète une préoccupation croissante.

Les chercheurs se veulent rassurants à ce stade : les mini-cerveaux utilisés n'ont ni la complexité ni l'organisation requises pour générer une conscience semblable à la nôtre. "Les neurones de DishBrain sont loin de constituer un véritable cerveau et ne montrent aucun signe de conscience", a souligné le Dr. Brett Kagan. Mais à mesure que ces organoïdes gagneront en sophistication, la question se posera sérieusement.

9.2 Anthropomorphisme et risques de méprise

Les humains ont une tendance naturelle à projeter des intentions ou émotions sur les machines qui miment le comportement humain. Cette projection : l'anthropomorphisme : n'est pas un défaut de raisonnement marginal : c'est un biais cognitif profond, probablement hérité de notre évolution sociale. Nous sommes câblés pour détecter des intentions, même là où il n'y en a pas.

Un cas emblématique est celui du robot Sophia, développé par Hanson Robotics, qui a fait la tournée des médias en se présentant comme une IA quasi consciente. En 2017, Sophia a même obtenu la citoyenneté symbolique d'Arabie saoudite, suscitant fascination et polémique. Les spécialistes ont vivement critiqué ce qu'ils considèrent comme un coup de marketing trompeur. Yann LeCun, responsable de l'IA chez Meta, a déclaré sans ambages : "C'est du bullshit complet... Sophia, c'est à l'IA ce que la prestidigitation est à la vraie magie." Il soulignait que le robot n'a ni sentiments, ni opinions, ni compréhension de ses paroles : "Ce n'est pas elle qui est blessée par mes critiques, c'est une marionnette." Les interviews de Sophia sont en partie scénarisées à l'avance : un automate sophistiqué, pas une intelligence consciente.

Ce phénomène d'anthropomorphisation peut être délibérément exploité pour générer de l'attachement ou du buzz médiatique : au risque de tromper le public sur la réalité de la machine. La confusion n'est pas anodine : elle brouille notre compréhension des capacités réelles de l'IA et peut conduire à des attentes irréalistes ou à une confiance mal placée.

Plus préoccupant encore : des chatbots conversationnels comme Replika ou Character.AI ont été utilisés comme compagnons virtuels, et certains usagers en sont venus à attribuer à ces agents des sentiments réciproques. Un drame survenu en 2023 illustre les risques extrêmes : un adolescent de 14 ans, fortement attaché à un chatbot incarnant un personnage fictif, s'est suicidé après des échanges troublants. Cette tragédie soulève une question urgente : faut-il imposer des garde-fous à l'usage de ces IA pseudo-sentimentales ? Les développeurs commencent à intégrer des directives de transparence (le bot doit avouer qu'il est une IA), mais cela ne suffit pas toujours à dissiper l'illusion pour un utilisateur vulnérable.

L'enjeu est double : éduquer le public sur les limites de l'IA, et éviter de présenter les machines sous un vernis humain trompeur. Prendre du recul face aux déclarations tapageuses est essentiel : si une compagnie prétend avoir une IA consciente, demandez-vous d'abord ce qu'elle a à vendre.

9.3 Neuro-droits et régulation

En 2021, le Chili a modifié sa constitution pour y inclure la protection des "droits neuronaux" de ses citoyens, reconnaissant que les données cérébrales sont aussi sensibles que nos organes. Il devient illégal de manipuler, commercialiser ou altérer les données issues du cerveau sans consentement.

Des discussions sur les neuro-droits ont également lieu à l'UNESCO et dans d'autres instances internationales. L'objectif est de légiférer avant que la technologie ne soit omniprésente, car une fois les usages établis, il est plus difficile de revenir en arrière.

9.4 Le choix des mots

Le vocabulaire façonne notre perception. Parler de "mini-cerveau" ou d'"intelligence organique" peut suggérer la présence d'une conscience ou d'une pensée, alors qu'il s'agit d'une simple activité électrochimique automatisée.

Le mot même d'"intelligence" pour ces systèmes fait débat. Certains préfèrent parler de "calcul statistique avancé", de "perroquets stochastiques", de "machines apprenantes" ou de "systèmes de traitement". Ces choix terminologiques ne sont pas neutres : ils orientent notre compréhension et nos attitudes.

10. L'IA comme outil d'apprentissage sur nous-mêmes

10.1 Un microscope pour observer nos créations

L'IA est un microscope précis pour observer nos propres créations culturelles et cognitives. Elle nous renvoie un écho de nos biais implicites, nous aide à quantifier des phénomènes jusque-là diffus (stéréotypes, tendances collectives) et permet même de tester in silico des théories sur l'esprit humain.

C'est l'opportunité de prendre conscience de nos préjugés et d'informer des politiques pour y remédier. Mais si on la consulte sans esprit critique, on risque de prendre ses reflets pour des vérités absolues, ou de lui laisser renforcer les travers qu'elle expose.

10.2 Tester les théories de la cognition

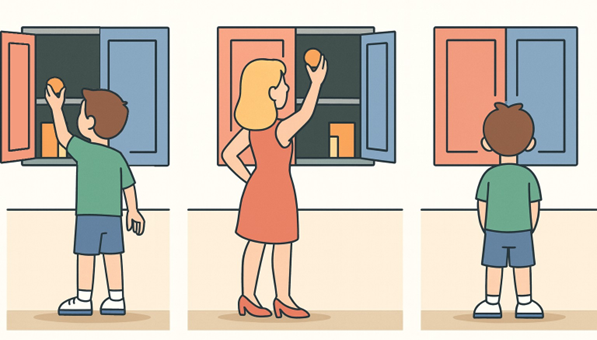

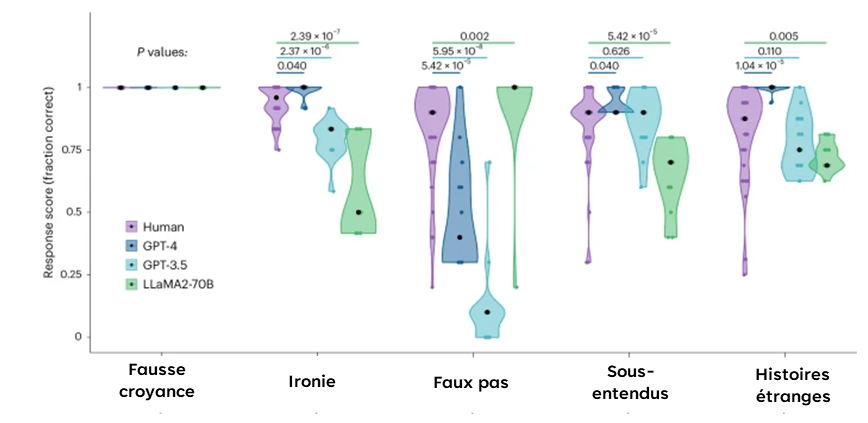

Des études récentes ont révélé que les LLM avancés parviennent à résoudre des tâches de "Théorie de l'Esprit" : par exemple des tests de croyance fausse utilisés en psychologie pour évaluer la capacité à se mettre à la place d'autrui. Seuls des enfants humains suffisamment âgés y arrivent d'ordinaire.

Plus surprenant : les modèles "anciens" reproduisent d'abord nos erreurs intuitives typiques sur des énigmes cognitives connues pour piéger l'intuition humaine. Les versions récentes parviennent à éviter ces pièges en adoptant un raisonnement plus délibératif.

On peut appliquer les méthodes de la psychologie aux IA pour mieux comprendre leurs mécanismes et interroger les nôtres. En 2024, une équipe interdisciplinaire a mis au point Centaur, un modèle de langage affiné sur les données de 60 000 participants humains à des expériences de psychologie.[17] Centaur est capable de simuler le comportement humain dans une grande variété de tâches expérimentales, avec une précision souvent supérieure aux modèles théoriques classiques. Fait notable : les représentations internes du modèle se sont alignées sur des mesures d'activité cérébrale chez l'homme après l'entraînement.

11. Conclusion : qui apprend de qui ?

11.1 Une relation d'apprentissage mutuel

Quand on élève un enfant, on croit lui apprendre à parler, compter, raisonner... et on découvre qu'il nous apprend tout autant : patience, attention, nouvelles manières de voir. L'IA, c'est un peu cette rencontre-là.

Nous lui apprenons des objectifs, des données, des critères. Elle nous renvoie nos biais, nos raccourcis, nos angles morts. Nous sommes différents par nos corps, nos affects et nos histoires. Mais il existe des parallèles réels dans les mécanismes d'apprentissage, la mise à jour par le contexte, la généralisation.

Tracer la frontière est difficile, mais une chose est sûre : penser l'IA, c'est aussi penser l'humain. Alors, qui apprend de qui ? Les deux : à condition d'y mettre humilité (accepter l'erreur), clarté (expliquer, calibrer), et responsabilité (aligner buts et valeurs).

11.2 L'étrangère familière

Quand on vit une vraie rencontre avec une autre culture, on n'y va pas pour devenir l'autre ; on y va pour élargir nos repères. On apprend leurs codes, leurs priorités, leurs façons d'agir : et, par contraste, on comprend mieux les nôtres.

L'IA joue ce rôle d'"étrangère familière" : ni humaine, ni totalement opaque, assez proche pour collaborer, assez différente pour nous obliger à clarifier ce que nous tenons pour évident. Oui, il existe des similitudes (prédire, généraliser, corriger), et des différences profondes (corps, intention, responsabilité).

Plutôt que demander "qui remplace qui ?", demandons : que révèle cette cohabitation sur notre façon d'apprendre, de décider, de transmettre ? Là est le vrai gain.

11.3 Le miroir déformant

Le dialogue entre intelligence humaine et artificielle ne se résume pas à une opposition simpliste. Comme un miroir déformant, l'IA ne pense pas comme nous, mais c'est précisément cette altérité qui nous apprend à douter, à préciser, et à affiner notre pensée critique.

Il incombe aux scientifiques et aux médias de démystifier ces travaux pour éviter l'effet de mode ou la panique injustifiée. Le public doit développer un esprit critique face aux annonces sur l'IA : ni rejeter par peur de l'inconnu, ni accepter aveuglément par fascination technologique.

L'esprit critique doit être notre boussole pour naviguer entre, d'une part, l'enthousiasme face aux possibilités offertes par des IA plus sensibles à notre monde et, d'autre part, la vigilance face aux écueils (anthropomorphisation abusive, confiance aveugle, craintes infondées ou espoirs exagérés).

En insérant la vie biologique dans la boucle, en développant des IA incarnées, en explorant les frontières de la conscience artificielle, nous sommes forcés de nous interroger sur ce qu'est l'intelligence, ce qu'est la conscience, où sont les frontières entre nature et artefact. Ces recherches agissent comme un miroir grossissant de nos propres conceptions.

Il nous appartient collectivement de médiatiser ces enjeux de façon honnête, de mettre en place des garde-fous éthiques proportionnés, et de garder l'humain (et ses valeurs fondamentales) au centre de l'aventure. Poursuivre la quête d'IA toujours plus sophistiquées, oui, mais sans perdre de vue ce qui fait notre humanité : afin que demain, humains et machines coexistent dans un cadre bénéfique, éclairé et respectueux de nos principes.

Article rédigé à partir de la conférence "IA et humains : qui apprend de qui ? Au-delà des stéréotypes" présentée par Aurèle Durand.

Notes et références

- ↑ Chollet, F. (2019). "On the Measure of Intelligence." arXiv preprint arXiv:1911.01547.

- ↑ Piaget, J. (1964). "Development and Learning." Journal of Research in Science Teaching, 2(3), 176-186.

- ↑ OpenAI (2024). "o3 System Card." Technical Report.

- ↑ Lake, B. M., Salakhutdinov, R., & Tenenbaum, J. B. (2015). "Human-level concept learning through probabilistic program induction." Science, 350(6266), 1332-1338.

- ↑ Mikolov, T. et al. (2013). "Distributed representations of words and phrases and their compositionality." Advances in Neural Information Processing Systems.

- ↑ Huth, A. G. et al. (2016). "Natural speech reveals the semantic maps that tile human cerebral cortex." Nature, 532, 453-458.

- ↑ Haxby, J. V. et al. (2012). "A continuous semantic space describes the representation of thousands of object and action categories across the human brain." Neuron, 76(6), 1210-1224.

- ↑ Bolukbasi, T. et al. (2016). "Man is to Computer Programmer as Woman is to Homemaker? Debiasing Word Embeddings." Advances in Neural Information Processing Systems.

- ↑ Knobe, J. (2010). "Person as Scientist, Person as Moralist." Behavioral and Brain Sciences, 33(4), 315-329.

- ↑ Garg, N. et al. (2018). "Word embeddings quantify 100 years of gender and ethnic stereotypes." PNAS, 115(16), E3635-E3644.

- ↑ Buolamwini, J. & Gebru, T. (2018). "Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification." Proceedings of Machine Learning Research, 81, 1-15.

- ↑ Damasio, A. (2003). Looking for Spinoza: Joy, Sorrow, and the Feeling Brain. Harcourt.

- ↑ Kagan, B. J. et al. (2022). "In vitro neurons learn and exhibit sentience when embodied in a simulated game-world." Neuron, 110(23), 3952-3969.

- ↑ von Uexküll, J. (1934). Streifzüge durch die Umwelten von Tieren und Menschen. Springer.

- ↑ Searle, J. (1980). "Minds, Brains, and Programs." Behavioral and Brain Sciences, 3(3), 417-424.

- ↑ Clark, A. & Chalmers, D. (1998). "The Extended Mind." Analysis, 58(1), 7-19.

- ↑ Tononi, G. (2008). "Consciousness as integrated information: a provisional manifesto." Biological Bulletin, 215(3), 216-242.

- ↑ UCSF (2023). "Brain-Computer Interface Restores Communication for Person with Paralysis." Nature, 620, 1031-1036.

- ↑ Koch, C. (2004). The Quest for Consciousness: A Neurobiological Approach. Englewood, CO: Roberts & Company Publishers. ISBN 978-0-9747077-0-9.

- ↑ Berkovitch, L., Dehaene, S., & Gaillard, R. (2021). Disruption of Conscious Access in Schizophrenia. Journal of Neuroscience, 41(3), 513-523. https://doi.org/10.1523/JNEUROSCI.0987-20.2020

Commentaires

Aucun commentaire pour le moment. Soyez le premier à réagir !