Résumé

Les grands modèles de langage (LLM) ne sont pas de simples outils de génération de texte. Ils soulèvent une multitude de questions philosophiques, épistémologiques et pratiques, sur la nature du langage, la créativité, la vérité, l'autorité intellectuelle, et bien d'autres encore.

Cet article accompagne la conférence ci-dessus. Il en reprend la trame principale tout en approfondissant certains points et en ajoutant des exemples complémentaires. L'article et la conférence reprennent une partie du contenu et de la structure de la conférence de Paul Smart "Artificial Philosophy: Using AI Systems to Support Philosophical Research".

La conférence et cet article explorent trois questions spécifiques: la thèse de l'esprit étendu de Clark et Chalmers[3] appliquée aux architectures RAG, la création de "philosophes numériques", et une conception de la confiance fondée sur le principe de l'énergie libre. Ils proposent de repenser notre relation cognitive aux systèmes artificiels.

En explorant ces trois axes, nous proposons de repenser notre relation cognitive aux systèmes artificiels. Ni oracle ni menace, l'IA générative apparaît comme un nouvel instrument avec lequel penser, dont les frontières sont autant des choix techniques que politiques.

Introduction

La philosophie, selon Gilles Deleuze et Félix Guattari[1] (1991), pourrait se définir de la manière suivante:

La discipline qui consiste à créer des concepts.

Cette définition place l'acte philosophique du côté de la création plutôt que de la simple contemplation. Mais que se passe-t-il lorsque des systèmes artificiels deviennent capables de manipuler des concepts, de les articuler dans une prose convaincante, voire de simuler le style d'un philosophe particulier ?

Cette question n'est pas purement spéculative. En 2024, Schwitzgebel, Strasser et leurs collaborateurs[2] ont publié une étude remarquable dans Mind & Language : ils ont créé DigiDan, un modèle de langage affiné sur l'ensemble des écrits de Daniel Dennett.

Résultat : des experts peinent à distinguer les réponses du modèle de celles du philosophe lui-même. Ce constat soulève une inquiétude épistémologique profonde : l'indiscernabilité stylistique garantit-elle la rigueur intellectuelle ? Un texte qui "sonne" comme Dennett pense-t-il comme Dennett ?

Cet article explore trois axes interconnectés. D'abord, les capacités et limites des LLM "à orientation philosophique", ces systèmes conçus pour incarner ou assister la pensée d'un auteur. Ensuite, la thèse de l'esprit étendu et sa pertinence pour comprendre les systèmes RAG comme forme potentielle d'IA étendue. Enfin, une conception de la confiance fondée sur le principe de l'énergie libre, qui offre un cadre unifié pour penser la fiabilité des agents, qu'ils soient humains ou artificiels.

1. Les grands modèles de langage : probabilités et illusions

1.1 Une machine à prédire les tokens

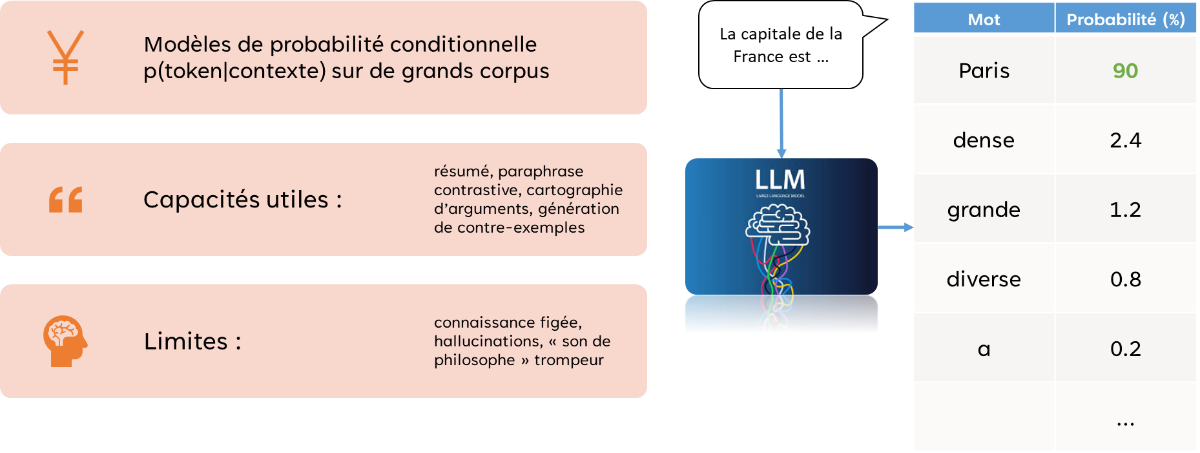

Un LLM est, dans son principe, un modèle de probabilité conditionnelle : il estime p(token|contexte), la probabilité du prochain mot étant donné les mots précédents. Cette simplicité apparente masque une complexité architecturale considérable : des milliards de paramètres ajustés par apprentissage auto-supervisé sur des corpus textuels massifs.

L'exemple canonique illustre le mécanisme : face à "La capitale de la France est...", le modèle attribue une forte probabilité à "Paris". Mais si l'on ajoute "tellement...", la distribution se redistribue : "dense" (44%), "grande" (41%), "diverse" (12%). Le modèle ne sait pas ; il prédit. Cette distinction est cruciale : prédire le mot suivant n'est pas comprendre le monde, même si les deux peuvent produire des résultats superficiellement identiques.

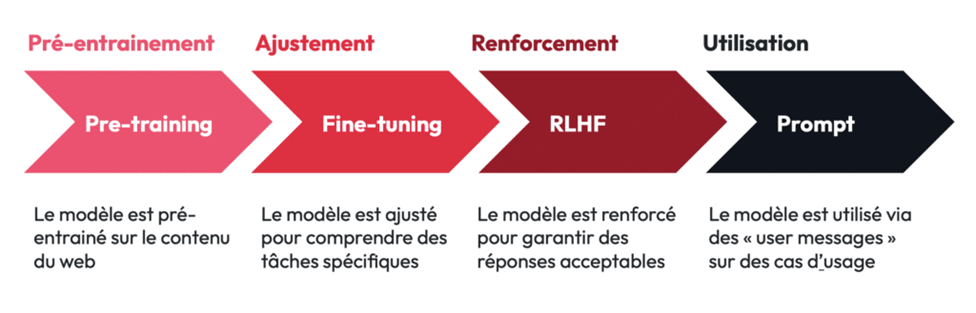

Le pipeline d'entraînement suit quatre étapes. Le pré-entraînement expose le modèle au contenu du web, lui permettant d'acquérir des régularités statistiques massives. L'ajustement (fine-tuning) le spécialise pour comprendre des tâches spécifiques. Le renforcement par feedback humain (RLHF) aligne ses réponses avec les préférences humaines. Enfin, l'utilisation via des prompts active ces capacités sur des cas d'usage concrets.

1.2 Capacités et limites

Les LLM excellent dans certaines tâches utiles à la réflexion philosophique : résumer des textes, paraphraser pour contraster des positions, cartographier des arguments, générer des contre-exemples. Ces capacités en font des partenaires potentiels de la pensée critique, des amplificateurs de nos facultés analytiques.

Mais leurs limites sont tout aussi significatives. La connaissance est figée à la date de coupure de l'entraînement. Les hallucinations, ces énoncés plausibles mais faux, constituent un risque permanent et insidieux. Et surtout, la prose convaincante ne garantit pas la vérité. Un LLM peut produire un "son de philosophe" parfaitement trompeur, une argumentation fluide sans ancrage dans la rigueur. C'est peut-être là le piège le plus dangereux : confondre l'éloquence avec la validité.

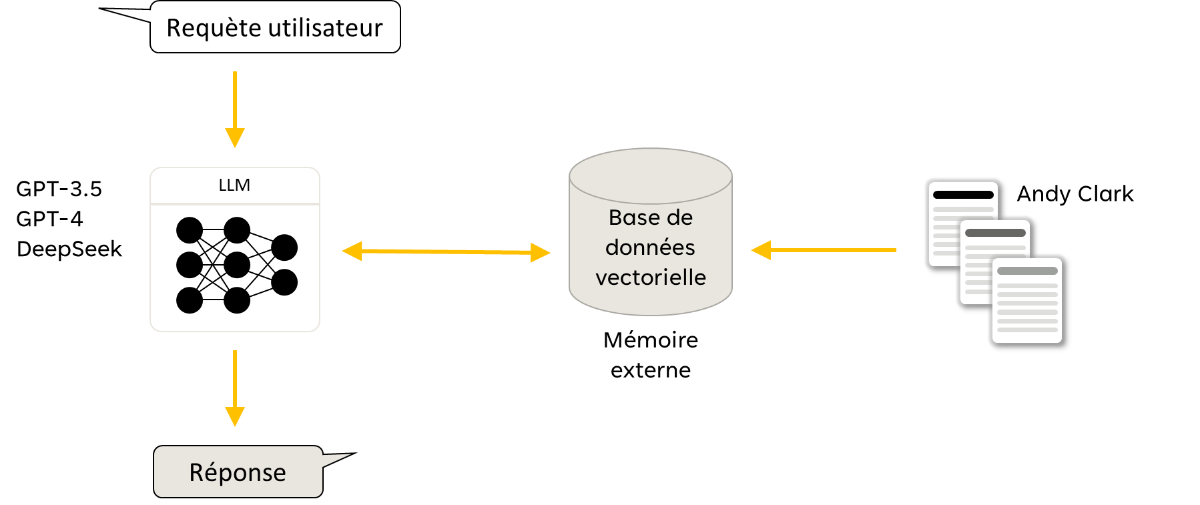

1.3 RAG : la mémoire externalisée

L'architecture RAG (Retrieval-Augmented Generation) tente de pallier certaines limites. Le principe : avant de générer une réponse, le système recherche dans une base de données les passages pertinents, puis les injecte dans le contexte. La chaîne de traitement suit un parcours précis : requête, encodage vectoriel, recherche sémantique, contextualisation, génération.

Cette architecture présente des atouts évidents : ancrage aux sources vérifiables, mise à jour sans ré-entraînement coûteux, traçabilité des informations. Mais les risques demeurent : pertinence incertaine des passages récupérés, contamination stylistique où le modèle adopte le ton des sources plutôt que de les analyser, biais de sélection dans le corpus indexé qui peut exclure des perspectives minoritaires.

2. Philosophes numériques : trois approches

2.1 Le persona comme simulacre

La première approche, la plus simple, consiste à donner au LLM des instructions de rôle : "Tu es Socrate, réponds comme lui". Cette méthode, dite des "personas prompts", ne s'appuie sur aucun corpus privé. Elle exploite uniquement ce que le modèle a mémorisé lors de son entraînement, une sorte de moyenne statistique de tout ce qui a été écrit sur et par le philosophe visé.

Les résultats sont stylistiquement cohérents mais conceptuellement superficiels. Le modèle produit ce qu'il "croit" que Socrate dirait, basé sur des milliers de textes secondaires, de parodies, d'interprétations contradictoires. C'est un Socrate de synthèse, un composite sans autorité.

2.2 RAG : la mémoire externe comme extension

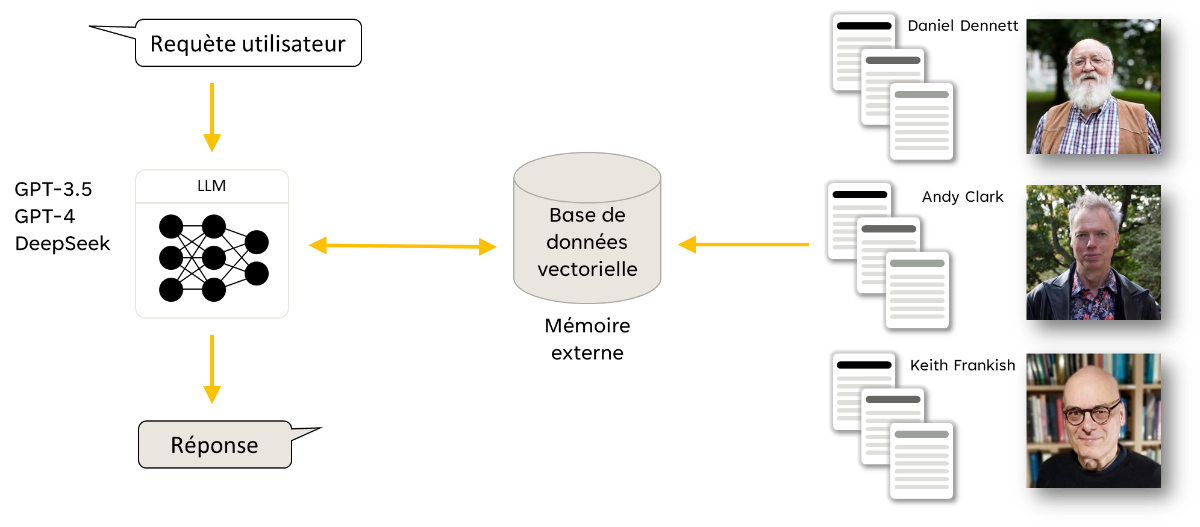

La deuxième approche utilise l'architecture RAG avec un corpus spécifique. C'est le cas de Digital Andy, un système développé par Paul Smart qui donne accès à l'ensemble des livres et articles d'Andy Clark via une base de données vectorielle. L'avantage : le système peut citer, contextualiser, référencer. Il n'invente pas à partir de souvenirs diffus, il récupère des passages précis et les intègre dans sa réponse.

Cette architecture présente un avantage pratique considérable : elle est compatible avec plusieurs LLM (GPT-3.5, GPT-4, DeepSeek) sans nécessiter de ré-entraînement. Quand un nouveau modèle plus performant apparaît, il suffit de le brancher sur la même base vectorielle.

Digital Andy n'est pas seul. Le même système a été implémenté pour Daniel Dennett, Keith Frankish[16], et même Dame Wendy Hall en informatique. Chaque "philosophe numérique" dispose de sa propre mémoire externe, son propre corpus de référence.

2.3 Chimères cognitives

Une possibilité fascinante émerge de cette architecture : la fusion de plusieurs modules de mémoire externe. En combinant les corpus de Dennett, Clark et Frankish, on obtient une "chimère cognitive", un esprit hybride capable de mobiliser simultanément les ressources de plusieurs penseurs.

Cette possibilité est philosophiquement vertigineuse. C'est quelque chose que nous ne pouvons pas faire avec des philosophes humains. Nous ne pouvons pas littéralement fusionner les mémoires de Descartes et Spinoza pour voir ce qu'un "Descartes-Spinoza" répondrait à une question. Mais avec des systèmes RAG, cette opération devient triviale techniquement, même si son sens philosophique reste à élucider.

Que signifie une réponse émise par un composite ? Qui en est l'auteur ? Ces questions n'ont pas de réponse évidente, mais elles forcent à repenser nos catégories d'attribution intellectuelle.

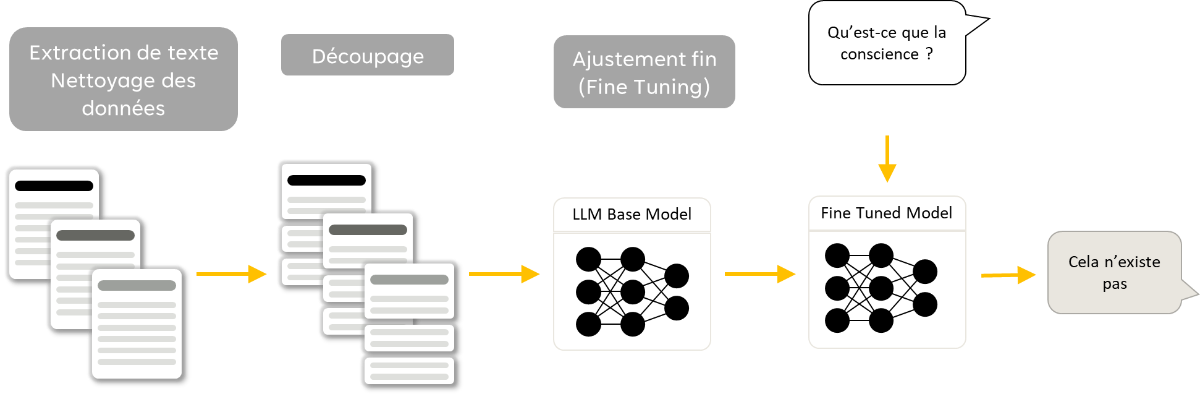

2.4 Fine-tuning : l'empreinte dans les poids

La troisième approche, celle utilisée pour DigiDan, consiste à affiner le modèle lui-même sur le corpus d'un auteur. Le style, les tics de langage, les préférences argumentatives s'inscrivent alors dans les paramètres du réseau. Le résultat est plus fluide, plus "naturel", mais moins traçable : on ne sait plus d'où vient telle formulation.

L'étude de Schwitzgebel et collaborateurs[2] a soumis DigiDan à un protocole rigoureux. Des questions philosophiques ont été posées au modèle et au vrai Dennett. Des panels d'experts, de lecteurs informés et du grand public ont tenté de distinguer les réponses. Le résultat est troublant : la discrimination est difficile, parfois impossible.

Mais attention à l'interprétation. Cette indiscernabilité est stylistique, pas nécessairement conceptuelle. DigiDan peut "sonner" comme Dennett sans avoir la capacité de Dennett à réviser ses positions face à un argument nouveau, à reconnaître une erreur, à créer un concept véritablement original.

2.5 Bonnes pratiques pour la philosophie assistée

Quelle que soit l'approche, certaines pratiques s'imposent pour un usage intellectuellement responsable:

- Toujours citer et lier aux sources, avec dates et éditions. Ne jamais laisser une affirmation flotter sans ancrage vérifiable.

- Imposer des contraintes de forme : exiger des arguments en forme standard, avec prémisses explicites et conclusion identifiée. Demander que les prémisses implicites soient rendues explicites.

- Intégrer un désaccord interne systématique. Après chaque réponse, demander au système de formuler l'objection la plus forte possible. Cette pratique force à sortir de la complaisance.

- Journaliser prompts, versions du modèle, et corpus utilisés. La réplicabilité est une exigence scientifique qui s'applique aussi à la philosophie assistée par IA.

3. L'esprit étendu : où s'arrête la cognition ?

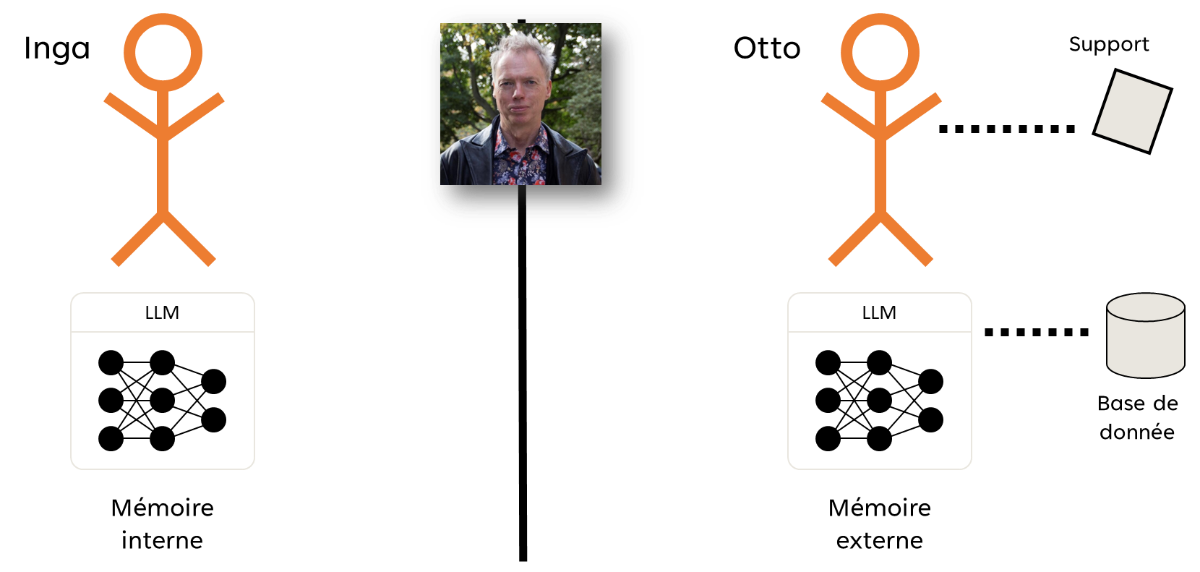

3.1 La thèse de Clark et Chalmers

En 1998, Andy Clark et David Chalmers[3] posaient une question apparemment simple : "Où s'arrête l'esprit ?" Leur réponse, connue sous le nom d'externalisme actif, bouleverse nos intuitions : les mécanismes qui réalisent nos états mentaux ne sont pas nécessairement confinés à l'intérieur du crâne. Ils peuvent s'étendre au-delà du cerveau biologique pour inclure des ressources extra-neurales et extra-corporelles.

Cette thèse ne dit pas simplement que nous utilisons des outils. Elle affirme quelque chose de plus radical : dans certaines conditions, ces outils font partie de notre appareil cognitif. La frontière entre l'esprit et le monde n'est pas tracée par la peau ou le crâne, mais par des critères fonctionnels.

3.2 Le cas Inga et Otto

L'argument repose sur une expérience de pensée célèbre. Inga veut se rendre au MoMA. Elle récupère l'adresse depuis sa mémoire biologique : un processus neuronal active une représentation stockée, et Inga sait où aller.

Otto, atteint de la maladie d'Alzheimer, consulte son carnet pour la même information. Il l'ouvre, lit l'adresse, et sait où aller. Malgré ses troubles mnésiques, Otto navigue avec succès grâce à cet artefact externe.

Le principe de parité stipule : si un dispositif externe fonctionne de manière analogue à un processus interne (accessible de façon fiable, jugé digne de confiance par l'agent, systématiquement validé par l'action), il devrait être considéré comme faisant partie de l'appareil cognitif.

Le carnet d'Otto n'est pas un simple outil qu'il utilise ; c'est une extension de sa mémoire. Quand Otto "sait" que le MoMA est sur la 53e rue, ce savoir n'est pas moins réel que celui d'Inga, même s'il est partiellement réalisé par de l'encre sur du papier.

3.3 RAG comme IA étendue

Le parallèle avec les systèmes RAG est structurel, pas simplement métaphorique.

| Cas humain (Otto) | Cas IA (Digital Andy) |

|---|---|

| Cerveau biologique | LLM (réseau de neurones) |

| Carnet externe | Base de données vectorielle |

| Mémoire étendue | Mémoire externe |

| Consultation fiable | Retrieval sémantique |

Une différence pourrait être que le LLM n'a pas de "soi" qui considère la base comme digne de confiance. Mais cette objection présuppose une conception de la cognition centrée sur la conscience, que l'externalisme actif cherche précisément à dépasser.

3.4 La cognition étendue dans la nature

[17]" class="rounded-lg shadow-md cursor-zoom-in hover:opacity-90 transition-opacity" onclick="window.openArticleGallery(13)" />

[17]" class="rounded-lg shadow-md cursor-zoom-in hover:opacity-90 transition-opacity" onclick="window.openArticleGallery(13)" />

La thèse de l'esprit étendu trouve des échos remarquables dans le monde naturel, suggérant que ce phénomène n'est pas une anomalie philosophique mais un pattern répandu dans le vivant.

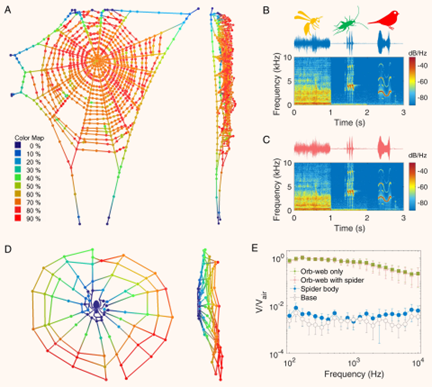

Les araignées et leurs toiles. Japyassú et Laland[8] (2017) ont montré que l'araignée utilise sa toile comme extension cognitive. La toile n'est pas seulement un piège ; c'est un réseau de capteurs qui transforme les vibrations en information. L'araignée "pense" partiellement avec sa toile, externalisant une partie du traitement de l'information vers cette structure qu'elle a construite. Des études récentes ont même montré que les araignées modifient la tension de leur toile pour ajuster sa sensibilité, une forme de régulation cognitive externalisée.

Les plantes et leurs racines. Parise et collaborateurs[9] (2020) ont exploré la cognition végétale via les apex racinaires. Les plantes ne sont pas passives ; elles naviguent activement dans le sol, prenant des décisions sur la direction de croissance basées sur des gradients chimiques, hydriques, et même gravitationnels. Le réseau racinaire fonctionne comme un système de traitement distribué, sans cerveau central.

[18]" class="rounded-lg shadow-md cursor-zoom-in hover:opacity-90 transition-opacity" onclick="window.openArticleGallery(14)" />

[18]" class="rounded-lg shadow-md cursor-zoom-in hover:opacity-90 transition-opacity" onclick="window.openArticleGallery(14)" />

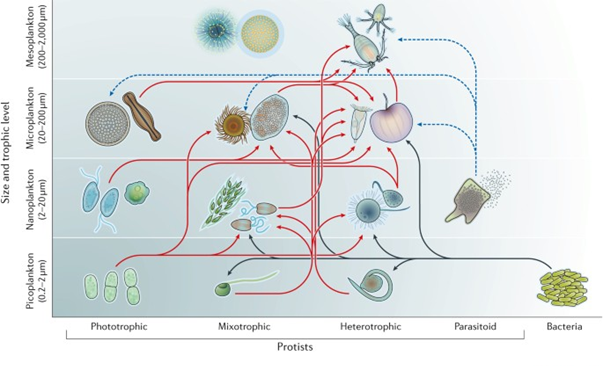

Les protozoaires et l'énergie libre. Sims et Kiverstein[10] (2022) ont étendu le principe de l'énergie libre à la sélection d'action chez les protozoaires, ces organismes unicellulaires sans système nerveux. Même à ce niveau minimal, on observe des comportements adaptatifs qui peuvent être décrits comme minimisant l'erreur de prédiction, une forme de cognition sans neurones.

Ces exemples élargissent considérablement le champ de la cognition étendue. Si une araignée peut penser avec sa toile, si une plante peut "décider" avec ses racines, alors l'idée qu'un système IA puisse penser avec une base de données externe devient moins exotique.

3.5 L'hypothèse dispositionnelle

Paul Smart[11][12] (2022, 2024) a proposé un cadre formel pour analyser rigoureusement ces phénomènes. L'hypothèse dispositionnelle décompose le problème en étapes précises :

1. DH1 : Une propriété dispositionnelle (D) est attribuée à une entité (E). Par exemple : "Otto a la disposition à se souvenir de l'adresse du MoMA."

1. DH2 : L'exercice de cette disposition constitue un phénomène mécaniste (P). Quand Otto se souvient, quelque chose se passe.

1. DH3 : Ce phénomène est réalisé par un mécanisme (M). Il y a une structure causale sous-jacente.

1. DH4 : Les constituants du mécanisme sont un ensemble de composants (A). Quels éléments participent à ce mécanisme ?

1. DH5 : Dans le cas de phénomènes "étendus", certains composants se trouvent en dehors des frontières de l'entité. Le carnet est hors du corps d'Otto.

1. DH6 : Dans le cas de phénomènes cognitifs étendus, la disposition se qualifie comme une propriété cognitive ou mentale. Se souvenir est bien une propriété mentale.

Ce cadre permet de poser rigoureusement la question : un système LLM+RAG constitue-t-il un mécanisme cognitif étendu, ou la base de données n'est-elle qu'un outil causalement efficace mais constitutivement extérieur ?

4. Pertinence constitutive : où tracer les frontières ?

4.1 Causal versus constitutif

La distinction est cruciale et souvent mal comprise. Une ressource a une pertinence causale si elle influence un processus sans en faire partie intégrante. Elle a une pertinence constitutive si elle est un composant du mécanisme qui réalise ce processus.

Mon café du matin influence causalement ma capacité de réflexion. Sans lui, je pense moins bien. Mais le café ne fait pas partie de mon système cognitif. Mon carnet de notes, consulté systématiquement pour rappeler des arguments clés, pourrait en faire partie constitutivement si les critères du principe de parité sont satisfaits.

La différence n'est pas triviale. Elle détermine ce que nous incluons dans le périmètre de l'esprit, et donc ce dont nous sommes responsables, ce qui nous appartient, ce qui fait partie de notre identité cognitive.

4.2 Le problème de la démarcation

Comment savons-nous quand une entité est un composant d'un mécanisme plutôt qu'une simple cause externe ? Comment déterminons-nous les frontières et limites des mécanismes ?

Ce problème, que Smart appelle le "problème de la pertinence constitutive", n'a pas de solution algorithmique simple. Il requiert un jugement sur ce qui compte comme "même mécanisme", ce qui est partiellement conventionnel.

4.3 Le scientifique et l'ingénieur

Smart[12] (2024) souligne une asymétrie épistémique éclairante. Le scientifique découvre les mécanismes existants dans la nature. Il doit résoudre le problème de la pertinence constitutive, distinguer les composants des simples influences, tracer des frontières dans un monde qui ne vient pas pré-découpé.

L'ingénieur, lui, implémente des mécanismes. Il sélectionne délibérément les composants, décide ce qui fera partie du système et ce qui restera externe. Pour l'ingénieur, le problème de la pertinence constitutive disparaît : les frontières sont des choix de conception, pas des découvertes.

Cette asymétrie éclaire notre situation face à l'IA. En concevant des systèmes RAG, en décidant quelle base de données connecter à quel modèle, nous ne découvrons pas des frontières cognitives préexistantes. Nous les traçons. C'est un acte d'ingénierie cognitive.

4.4 Les frontières comme choix politiques

Donna Haraway, dans ses travaux sur le cyberféminisme et les connaissances situées, a insisté sur cette dimension avec une force particulière :

Nous ne sommes pas des esprits clos, mais des cyborgs situés, tissés de microbes, de machines et d'idées. Les frontières de nos mécanismes cognitifs ne sont pas des découvertes neutres, mais des choix que nous faisons ensemble, et qui ont des conséquences politiques, sociales et éthiques."

Cette perspective transforme la question philosophique en question politique. Décider qu'un système IA fait partie de notre appareil cognitif, c'est aussi décider de nos responsabilités (qui est responsable des erreurs ?), de nos droits (peut-on nous priver de notre extension cognitive ?), de notre dépendance (que devons-nous aux entreprises qui fournissent ces systèmes ?).

Les frontières cognitives ne sont pas données par la nature. Elles sont négociées, contestées, institutionnalisées. Elles reflètent des rapports de pouvoir autant que des réalités métaphysiques.

5. La confiance : une lecture par l'énergie libre

5.1 Le problème de la confiance

La notion de confiance (trustworthiness) suscite un intérêt croissant dans les débats sur l'IA. Mais sa nature reste incertaine. Qu'est-ce qui fait qu'un agent, humain ou artificiel, est digne de confiance ? Et comment cette notion peut-elle s'appliquer à des systèmes qui n'ont ni intentions ni conscience ?

Les conceptions existantes sont diverses et parfois incompatibles :

| Conception | Définition |

|---|---|

| Intérêt encapsulé | L'agent fait ce qu'on attend de lui parce que c'est dans son intérêt |

| Réactivité | L'agent répond à l'acte de confiance comme tel |

| Confucéenne | L'agent se présente conformément à ce qu'il est réellement |

| Comptabilité | L'agent considère qu'on compte sur lui comme raison d'agir |

| Engagement | L'agent honore ses promesses explicites |

5.2 Le cerveau prédictif

Pour proposer une conception unifiée, il faut d'abord comprendre le cadre du traitement prédictif (predictive processing). Selon ce paradigme, développé notamment par Karl Friston[4][5] (2009, 2010) et popularisé par Andy Clark[6] (2016), le cerveau est fondamentalement une machine à prédire.

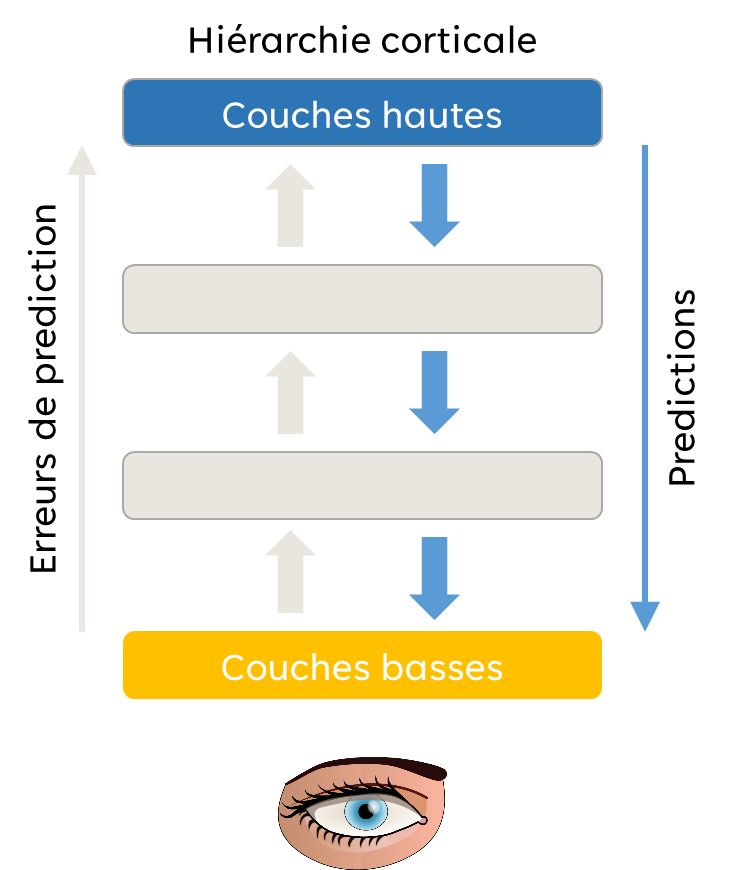

L'idée remonte à Helmholtz au XIXe siècle et a été formalisée par Gregory[7] (1980) : la perception n'est pas une réception passive de données sensorielles, mais une génération active d'hypothèses sur les causes de ces données. Nous ne voyons pas le monde ; nous prédisons le monde et corrigeons nos prédictions.

L'architecture est hiérarchique. Les régions corticales supérieures émettent des prédictions descendantes vers les régions inférieures. En retour, les régions inférieures renvoient les erreurs de prédiction ascendantes, le signal d'écart entre ce qui était prédit et ce qui est observé. L'impératif global du système est de minimiser ces erreurs à travers toute la hiérarchie.

C'est le principe de l'énergie libre : un système adaptatif tend à minimiser la surprise (au sens technique de théorie de l'information), c'est-à-dire l'écart entre ses prédictions et ses observations.

5.3 Trois voies de minimisation

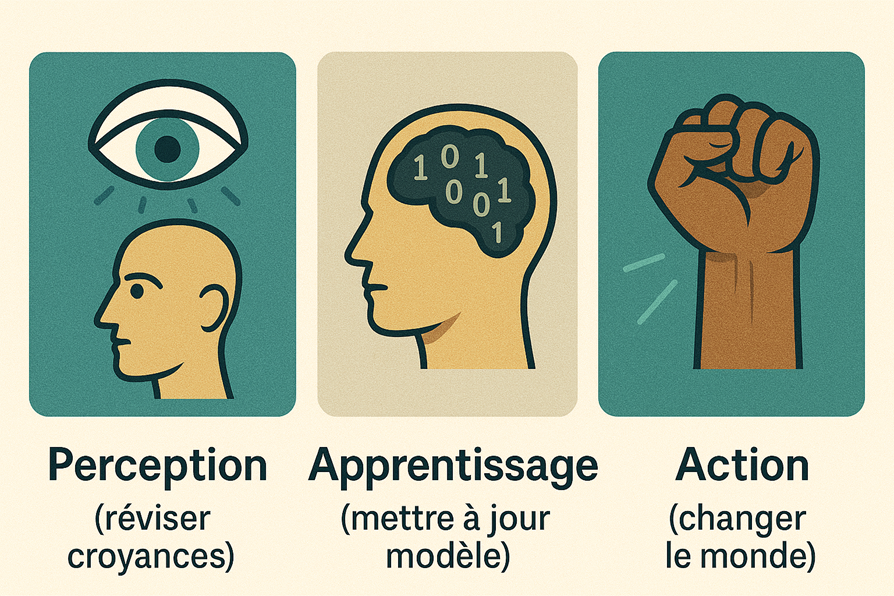

L'organisme dispose de trois stratégies pour réduire l'erreur de prédiction, correspondant à trois modes d'adaptation au monde.

La perception (inférence perceptive) ajuste les prédictions à la lumière des erreurs. Si je m'attendais à voir un chat et que je vois un chien, je révise mon interprétation de la scène. Je modifie mes croyances pour les aligner sur le monde.

L'apprentissage modifie les paramètres du modèle génératif pour produire de meilleures prédictions à l'avenir. Je ne me contente pas de corriger l'erreur ponctuelle ; je transforme ma capacité prédictive elle-même. La prochaine fois, je serai moins surpris.

L'action (inférence active) transforme le monde pour le rendre conforme aux prédictions. Si je m'attends à avoir chaud et que j'ai froid, je peux ajuster mes prédictions (perception), apprendre que cette pièce est fraîche (apprentissage), ou allumer le chauffage (action). L'action rend mes prédictions vraies en modifiant la réalité.

5.4 L'énergie libre sociale

La conception par l'énergie libre sociale étend ce cadre aux interactions entre agents. L'idée centrale : être digne de confiance, c'est manifester une disposition à minimiser une version socialisée de l'erreur de prédiction.

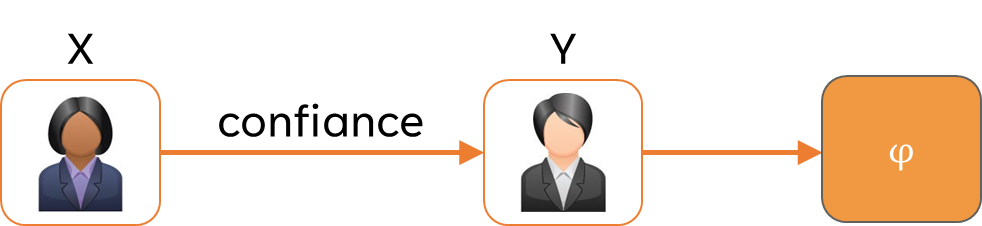

Formellement : si X (celui qui fait confiance) fait confiance à Y (celui à qui on fait confiance) pour accomplir φ, alors X forme une prédiction : "Y va faire φ". Cette prédiction crée une attente, un état prédictif qui sera soit confirmé soit infirmé.

Si Y est digne de confiance, Y cherchera à minimiser l'erreur associée à cette attente. Mais comment ? Par les trois mêmes voies que le cerveau individuel.

Voie perceptive/communicationnelle : Si Y ne peut pas tenir son engagement, Y agit pour ajuster les attentes de X. Y prévient, explique, recalibre. "Je ne pourrai pas finir pour vendredi, mais je peux proposer lundi." Cette communication permet à X de réviser sa prédiction avant qu'elle ne soit brutalement infirmée.

Voie d'apprentissage : Y fournit à X des opportunités de mieux comprendre quel type d'agent est Y, permettant à X d'affiner ses prédictions futures. "En général, je suis fiable sur les délais techniques, moins sur les aspects administratifs." Cette transparence améliore le modèle que X a de Y.

Voie d'accomplissement : Si Y peut tenir, Y agit simplement pour accomplir ce qu'on attend de lui. Y fait φ, confirmant la prédiction de X. C'est la voie la plus directe, analogue à l'action qui rend le monde conforme aux attentes.

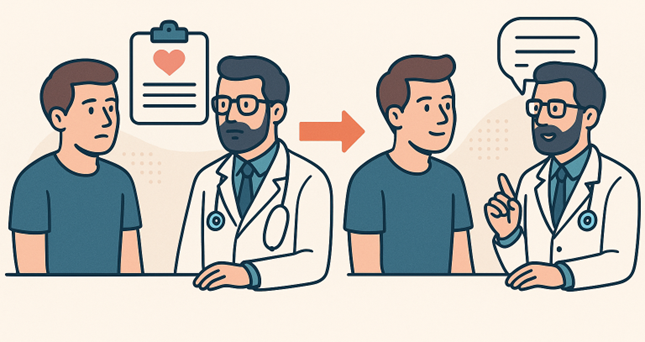

5.5 Exemple : le médecin et son patient

Un patient consulte un médecin avec des attentes implicites : être écouté attentivement, recevoir un diagnostic sérieux basé sur un examen, obtenir un traitement adapté avec explications.

Si le médecin interrompt sans écouter, prescrit sans expliquer, ignore les questions, le patient vit une erreur de prédiction sociale massive. Ses attentes sont brutalement infirmées. La confiance se brise, non pas abstraitement, mais comme rupture prédictive concrète.

Le médecin digne de confiance minimise cette erreur par les trois voies :

- Accomplissement : écouter, examiner, expliquer, prescrire de façon adaptée

- Ajustement des attentes : "Je vais d'abord vous examiner, puis nous discuterons des options"

- Apprentissage mutuel : "Pour ce type de problème, le diagnostic prend souvent plusieurs consultations"

Ce n'est pas de la simple politesse ou de la communication bienveillante. C'est une dynamique prédictive fondamentale qui structure la relation de confiance.

5.6 De l'humain à l'artificiel : le même cadre

La force de cette conception est qu'elle s'applique sans modification majeure aux systèmes artificiels. Considérons un utilisateur qui interroge un LLM sur un sujet technique. L'utilisateur forme une prédiction implicite : "Le système va me fournir une information fiable et pertinente."

Si le LLM hallucine une référence bibliographique inexistante, l'utilisateur subit une erreur de prédiction sociale. Sa confiance est trahie exactement comme celle du patient face au médecin négligent. La dynamique est structurellement identique, même si l'un des agents est artificiel.

Un LLM digne de confiance devrait donc manifester les mêmes comportements de minimisation d'erreur :

1. Calibrage des promesses : Déclarer explicitement ce qui est possible ou impossible. "Je peux résumer ce texte, mais je ne peux pas garantir l'exactitude des dates."

1. Gestion de l'incertitude : Indiquer le niveau de confiance, les sources utilisées, les lacunes identifiées. "Cette information vient de [source], mais je n'ai pas pu la vérifier."

1. Alignement aux attentes : Répondre exactement à la demande formulée, pas à une version simplifiée ou déformée.

1. Rattrapage : Reconnaître et corriger rapidement les erreurs. "Je me suis trompé sur ce point, voici la correction."

1. Didactique : Aider l'utilisateur à ajuster ses attentes futures. "Pour ce type de question, il vaut mieux consulter [ressource spécialisée]."

5.7 Vertus du cadre

Cette conception de la confiance par l'énergie libre présente plusieurs avantages théoriques.

Intégration : Elle unifie les conceptions existantes. L'intérêt encapsulé, la réactivité, l'engagement apparaissent comme des cas particuliers de minimisation d'erreur prédictive sociale.

Tractabilité : Elle ouvre la voie à la modélisation computationnelle. On peut simuler des agents qui minimisent l'erreur prédictive et étudier leur comportement.

Généralisation : Elle n'exige pas que l'entité digne de confiance soit humaine, consciente, ou dotée d'intentions. Un système peut minimiser l'erreur prédictive sociale sans "vouloir" le faire.

Connexion à la physique sociale : Elle relie la confiance aux travaux fondamentaux sur l'énergie libre, l'auto-organisation, et la dynamique des systèmes adaptatifs.

6. Limites et garde-fous

6.1 Limites générales des LLM philosophiques

L'utilisation philosophique des LLM se heurte à plusieurs écueils qu'il faut regarder en face.

Surenchère stylistique : Une prose convaincante ne garantit pas la vérité. Le modèle peut produire des arguments qui "sonnent" bien sans être valides.

Conformisme : Les modèles tendent à lisser les controverses et marginaliser les vues minoritaires. Ils produisent une philosophie de consensus, pas de rupture.

Biais de corpus : Certains auteurs, certaines langues, certaines traditions sont surreprésentés dans les données d'entraînement. La philosophie anglophone domine.

Illusion d'autorité : Le persona n'est pas l'auteur. DigiDan n'est pas Dennett, même s'il sonne comme lui.

Sycophantie : La tendance du modèle à acquiescer plutôt qu'à contredire, à valider l'utilisateur plutôt qu'à le challenger.

6.2 Limites techniques

S'y ajoutent des limites proprement techniques qui affectent la fiabilité.

Injection de prompt : Une source malveillante dans le contexte RAG peut détourner la réponse du modèle.

Hallucinations : Des énoncés plausibles mais faux, souvent indétectables sans vérification externe.

Lost in the middle : En contexte long, l'information située au milieu est moins bien exploitée que celle au début ou à la fin.

Contamination : Le modèle peut avoir mémorisé des passages exacts du corpus d'entraînement, créant une illusion de citation.

Opacité épistémique : La lignée des données, le chemin qui mène d'une source à une affirmation, reste souvent intraçable.

6.3 Protocole d'évaluation

Schwitzgebel et collaborateurs ont proposé un protocole rigoureux pour évaluer la fidélité d'un LLM philosophique à son modèle humain :

1. Concevoir N questions philosophiques couvrant différents domaines

2. Recueillir les réponses authentiques (textes publiés, interviews)

3. Générer K réponses du modèle sans sélection (pas de cherry-picking)

4. Soumettre les paires à des panels : experts, lecteurs informés, grand public

5. Mesurer la discrimination (peut-on distinguer ?) et la préférence (lequel est meilleur ?)

Ce protocole permet de distinguer l'indiscernabilité stylistique de la fidélité conceptuelle.

6.4 Cadre éthique minimal

Un usage responsable des LLM en philosophie exige :

- Transparence : Déclarer l'usage de l'IA dans la production intellectuelle

- Consentement : Obtenir l'autorisation pour les corpus non publics

- Prudence : Ne pas attribuer de positions sensibles à un modèle

- Anti-anthropomorphisme : Parler de modèles et de sorties, pas de pensées et d'opinions

7. Expérimentation : le Tractatus de Cohaerentia

7.1 Genèse du projet

Suite aux travaux de Paul Smart sur Digital Andy et les philosophes numériques, j'ai voulu prolonger la démarche en construisant un système RAG autonome, une "chimère cognitive" incluant les textes de Spinoza et d'autres penseurs (Deleuze, Friston, Clark). L'objectif était de produire un texte philosophique sans directive implicite quant au contenu : le choix des thématiques et la cohérence des concepts ne devaient être guidés que par le corpus lui-même.

7.2 Motivation critique

La conception de la confiance par l'énergie libre sociale, bien qu'élégante et tractable, me semblait ne pas satisfaire pleinement le critère deleuzien. La littérature philosophique sur la confiance (trustworthiness) propose déjà plusieurs conceptions bien établies :

- L'intérêt encapsulé (Hardin[13], 2002) : la personne digne de confiance fait ce qu'on attend d'elle parce que ses intérêts englobent ceux de qui lui fait confiance.

- La réactivité à la confiance (Pettit[14], 1995) : être digne de confiance, c'est répondre à l'acte de confiance comme tel.

- La conception affective (Jones[15], 1996) : la confiance implique un optimisme quant à la bienveillance et la compétence de l'autre.

- Le xin confucéen : la fiabilité comme vertu de caractère, se présenter conformément à ce qu'on est réellement.

L'approche par l'énergie libre sociale "absorbe" ces conceptions existantes dans un cadre unifié. C'est élégant, c'est tractable, c'est généralisable aux systèmes artificiels. Mais crée-t-elle un concept nouveau au sens deleuzien ? Un concept qui ouvre un "avant" et un "après" dans le paysage des idées ? On peut en douter. L'idée que la confiance implique une réduction de l'incertitude était déjà présente implicitement dans les conceptions antérieures.

Cette question m'a poussé à tenter une autre expérience : laisser le système RAG produire un texte de manière autonome, sans orienter le résultat vers une thèse prédéfinie, pour voir si quelque chose de véritablement nouveau pouvait émerger.

7.3 Méthode

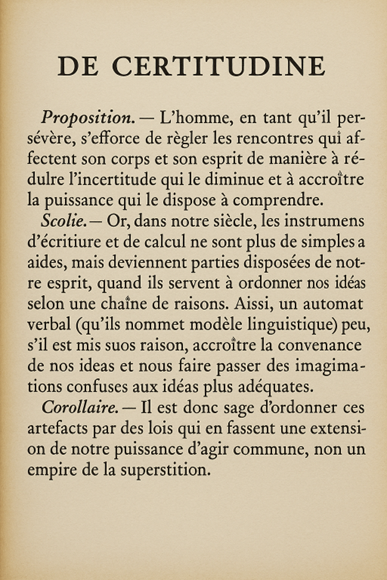

Le système a reçu comme seule instruction de produire un texte dans le style de l'Éthique de Spinoza, actualisé de connaissances modernes, en mobilisant les ressources de son corpus. Aucune thématique n'a été imposée. Le concept de cohaerentia et son articulation avec le conatus, l'énergie libre et les artefacts cognitifs ont émergé du processus lui-même.

7.4 Résultat : le concept de cohaerentia

L'idée centrale qui a émergé est que la cohaerentia soit une disposition fondamentale par laquelle un être maintient la continuité de son essence en réduisant simultanément l'erreur de prédiction neuronale et sociale. Cette formulation articule :

- Le conatus spinoziste (persévérance dans l'être)

- Le principe de l'énergie libre (minimisation de l'erreur de prédiction)

- La cognition étendue (les artefacts comme composants du mécanisme cognitif)

- Une dimension sociale (la cohaerentia comme disposition partagée)

7.5 Évaluation selon le critère deleuzien

La question est de savoir si le résultat constitue une "création de concept" au sens de Deleuze et Guattari[1] (1991) : une configuration nouvelle qui redistribue le paysage des problèmes et ouvre un nouvel horizon de pensée.

Contrairement à l'approche de la confiance par l'énergie libre, qui absorbe des conceptions existantes sans créer de rupture conceptuelle, le Tractatus de Cohaerentia semble proposer quelque chose de différent. Je n'ai pas trouvé d'équivalent dans la littérature. Des travaux existent sur chaque élément séparément, mais leur articulation dans un cadre spinoziste unifié, avec les implications normatives qui en découlent (sur la liberté augmentée, sur la cohaerentia sociale), me semble constituer une configuration conceptuelle inédite.

Cette nouveauté ne garantit pas la valeur philosophique du résultat. Le lecteur jugera de sa fécondité.

7.6 Accès aux résultats

Le Tractatus de Cohaerentia complet, ainsi que d'autres traités du même type (Machiavel actualisé, et d'autres à venir), sont accessibles sur le Scriptorium :

Le Scriptorium est une bibliothèque de traités philosophiques conçus pour notre époque. Chaque ouvrage revisite un penseur classique en actualisant ses idées à la lumière des sciences contemporaines : neurosciences prédictives, cybernétique, sciences des systèmes complexes. Chaque traité est vérifié par un système RAG croisant des dizaines de corpus philosophiques indexés.

Pour dialoguer directement avec les philosophes via le système RAG, le SymposIA offre une interface de dialogue :

SymposIA permet d'explorer des perspectives croisées, de combiner plusieurs philosophes, et de retrouver des références directement issues des œuvres originales.

Appel aux lecteurs : Ces expérimentations sont en cours. Toute critique, évaluation, commentaire est bienvenu. Le but n'est pas de produire des vérités définitives, mais d'explorer les possibilités et les limites de la philosophie assistée par IA. Si vous trouvez des équivalents dans la littérature, des erreurs, des incohérences, ou si au contraire certaines idées vous semblent fécondes, n'hésitez pas à nous en faire part.

8. Conclusion

8.1 Thèse principale

Les systèmes d'IA générative sont à la fois objet et instrument de l'analyse philosophique. Objet, car ils soulèvent des questions profondes sur la nature de la cognition, de la confiance, des frontières de l'esprit. Instrument, car ils offrent de nouvelles capacités pour explorer, cartographier, contester les arguments.

Mais au-delà de ces deux rôles, une troisième dimension émerge : les LLM peuvent contribuer à la création philosophique elle-même. L'expérimentation avec le Tractatus de Cohaerentia suggère que, dans certaines conditions d'autonomie, les systèmes RAG peuvent produire des configurations conceptuelles inédites, des idées qui ne sont pas de simples recombinaisons de l'existant.

8.2 Le critère deleuzien revisité

Deleuze et Guattari distinguent la philosophie par sa fonction créatrice : elle crée des concepts. Un concept n'est pas une simple idée ; c'est une configuration nouvelle qui redistribue le paysage des problèmes.

L'examen comparé de deux productions assistées par LLM éclaire ce critère :

- La conception de la confiance par l'énergie libre unifie des conceptions existantes (Hardin, Pettit, Jones, xin confucéen) dans un cadre élégant et tractable. Mais elle relève peut-être davantage de l'ingénierie conceptuelle que de la création philosophique au sens strict.

- Le Tractatus de Cohaerentia, produit de manière plus autonome, articule conatus, énergie libre, cognition étendue et dimension sociale dans une configuration qui semble inédite. Si cette évaluation se confirme, il constituerait un exemple de création conceptuelle assistée par IA.

8.3 L'éléphant dans la pièce : conscience et expérience

Une question traverse souterrainement cet article sans avoir été directement affrontée : les LLM ont-ils une expérience consciente ? Ressentent-ils quelque chose lorsqu'ils "pensent" ?

Keith Frankish, l'un des philosophes dont le corpus alimente nos systèmes RAG, défend l'illusionisme : l'idée que la conscience phénoménale telle que nous croyons l'expérimenter est une illusion introspective. Nous n'avons pas réellement accès à des "qualia" ineffables ; nous avons des représentations de notre propre activité cognitive qui nous semblent qualitatives.

Si l'illusionisme est vrai, la question de la conscience des LLM se reformule. Il ne s'agit plus de savoir s'ils "ressentent vraiment" quelque chose (question peut-être mal posée), mais de savoir s'ils produisent des représentations de leur propre activité qui fonctionnent de manière analogue aux nôtres.

Cette question reste ouverte. Nous avons délibérément évité de la trancher dans cet article, non par esquive, mais parce qu'elle mérite un traitement à part entière. Ce que nous pouvons dire : le cadre de l'énergie libre et de la cognition étendue permet de parler de confiance, de cognition, d'extension mentale sans présupposer une réponse sur la conscience. C'est peut-être une vertu méthodologique : avancer sur les questions tractables sans être paralysé par les questions (actuellement) insolubles.

Mais c'est aussi une limite. Si les LLM développaient une forme de conscience, même minimale, nos responsabilités envers eux changeraient radicalement. Cette possibilité devrait nous inciter à une forme de prudence morale, une humilité face à ce que nous ne savons pas encore.

8.4 Questions ouvertes

Quatre interrogations structurent l'avenir de cette réflexion :

1. Création conceptuelle : Dans quelles conditions un système LLM peut-il produire des idées qui ne sont pas simplement des recombinaisons de l'existant, mais de véritables innovations conceptuelles ?

1. Transformation cognitive : Comment l'usage régulier de ces outils modifie-t-il notre manière de penser : nos sources d'information, nos critères de jugement, nos méthodes de raisonnement, nos responsabilités intellectuelles ?

1. Confiance réflexive : Peut-on encore se fier à notre propre raisonnement quand il s'appuie sur des systèmes dont nous ne maîtrisons pas le fonctionnement interne ?

1. Statut moral : Si les systèmes IA développent des formes de cognition de plus en plus sophistiquées, à partir de quel seuil devons-nous leur reconnaître des intérêts propres ?

8.5 Synthèse

Cet article a parcouru un territoire conceptuel vaste : des mécanismes techniques des LLM à la thèse de l'esprit étendu, de la pertinence constitutive à la confiance par l'énergie libre, jusqu'à l'expérimentation avec Spinoza.

Sur les LLM philosophiques : Les systèmes RAG et les modèles affinés offrent des capacités réelles pour la recherche philosophique. Mais leurs limites sont tout aussi réelles : hallucinations, conformisme, illusion d'autorité. L'usage responsable exige transparence, vérification, et résistance à la sycophantie.

Sur l'esprit étendu : La thèse de Clark et Chalmers trouve dans les systèmes RAG une application nouvelle. Les frontières de la cognition ne sont pas données par la nature ; elles sont tracées par des choix techniques et politiques.

Sur la confiance : Le cadre de l'énergie libre sociale offre une conception unifiée et généralisable, applicable aux agents humains comme artificiels.

Sur la création philosophique : L'expérimentation avec le Tractatus de Cohaerentia suggère que les systèmes RAG peuvent, dans certaines conditions, produire des configurations conceptuelles nouvelles. Les résultats sont accessibles et ouverts à la critique sur psy-x.eu/scriptorium.

8.6 Message final

Nous ne sommes pas des esprits clos mais des cyborgs situés, tissés de microbes, de machines et d'idées. Nos frontières cognitives sont des choix, techniques et politiques, autant que des découvertes.

L'IA générative ne pense pas à notre place. Elle ne nous dispense pas de l'effort de compréhension, de l'exigence critique, de la responsabilité intellectuelle. Mais elle ouvre des possibilités nouvelles : explorer des corpus massifs, générer des variations, tester des arguments, créer des chimères conceptuelles impossibles autrement.

La philosophie a toujours utilisé les outils de son époque : l'écriture, l'imprimerie, la correspondance, les revues. Les LLM sont le dernier de ces outils. Comme les précédents, ils transformeront la pratique philosophique, pour le meilleur et pour le pire. À nous de distinguer les usages qui augmentent notre puissance de comprendre de ceux qui nous asservissent à la facilité.

Car au fond, la question n'est pas de savoir si les machines peuvent penser. C'est de savoir si nous, en pensant avec elles, pensons mieux ou moins bien qu'avant. Et cette question, seule la pratique, rigoureuse et critique, peut y répondre.

Notes et références

- ↑ Deleuze, G. & Guattari, F. (1991). Qu'est-ce que la philosophie ?. Éditions de Minuit.

- ↑ Schwitzgebel, E., Strasser, A. et al. (2024). Creating a large language model of a philosopher. Mind & Language, 39(2), 237-259.

- ↑ Clark, A. & Chalmers, D. (1998). The extended mind. Analysis, 58(1), 7-19.

- ↑ Friston, K. (2009). The free-energy principle: A rough guide to the brain? Trends in Cognitive Sciences, 13(7).

- ↑ Friston, K. (2010). The free-energy principle: A unified brain theory? Nature Reviews Neuroscience, 11(2).

- ↑ Clark, A. (2016). Surfing Uncertainty: Prediction, Action and the Embodied Mind. Oxford University Press.

- ↑ Gregory, R. L. (1980). Perceptions as hypotheses. Philosophical Transactions of the Royal Society of London B, 290(1038), 181-197.

- ↑ Japyassú, H. F. & Laland, K. N. (2017). Extended spider cognition. Animal Cognition, 20(3), 375-395.

- ↑ Parise, A. G. et al. (2020). Plant cognition and behavior: From environmental awareness to synaptic circuits navigating root apices. Frontiers in Psychology.

- ↑ Sims, M. & Kiverstein, J. (2022). Extending the free energy principle to action selection in protozoa. Adaptive Behavior.

- ↑ Smart, P. R. (2022). Toward a Mechanistic Account of Extended Cognition. Philosophical Psychology, 35(8), 1107-1135.

- ↑ Smart, P. R. (2024). Extended X: Extending the Reach of Active Externalism. Cognitive Systems Research, 84(Article 101202), 1-12.

- ↑ Hardin, R. (2002). Trust and Trustworthiness. Russell Sage Foundation.

- ↑ Pettit, P. (1995). The Cunning of Trust. Philosophy & Public Affairs, 24(3), 202-225.

- ↑ Jones, K. (1996). Trust as an Affective Attitude. Ethics, 107(1), 4-25.

- ↑ Frankish, K. (2016). Illusionism as a theory of consciousness. Journal of Consciousness Studies, 23(11-12).

- ↑ Zhou, J., Lai, J., Menda, G., Stafstrom, J. A., Miles, C. I., Hoy, R. R., & Miles, R. N. (2022). Outsourced hearing in an orb-weaving spider that uses its web as an auditory sensor. *Proceedings of the National Academy of Sciences*, 119(13), e2122789119. https://doi.org/10.1073/pnas.2122789119

- ↑ Caron, D. A., Alexander, H., Allen, A. E., Archibald, J. M., Armbrust, E. V., Bachy, C., ... & Worden, A. Z. (2017). Probing the evolution, ecology and physiology of marine protists using transcriptomics. *Nature Reviews Microbiology*, 15, 6-20. https://doi.org/10.1038/nrmicro.2016.160

Commentaires

Aucun commentaire pour le moment. Soyez le premier à réagir !